Spring 微服务

从单体架构过度到微服务架构,需要一系列中间技术支撑,其中重要的部分包括:

注册中心:Eureka 、Zookeeper、Nacos

服务网关:Zuul 、Gateway

微服务远程调用:RestTemplate、Feign

容器化技术 Docker

消息队列 MQ(多种实现方式)

负载均衡 Ribbon 、 Nginx

分布式搜索技术:ElasticSearch

2.Eureka注册中心

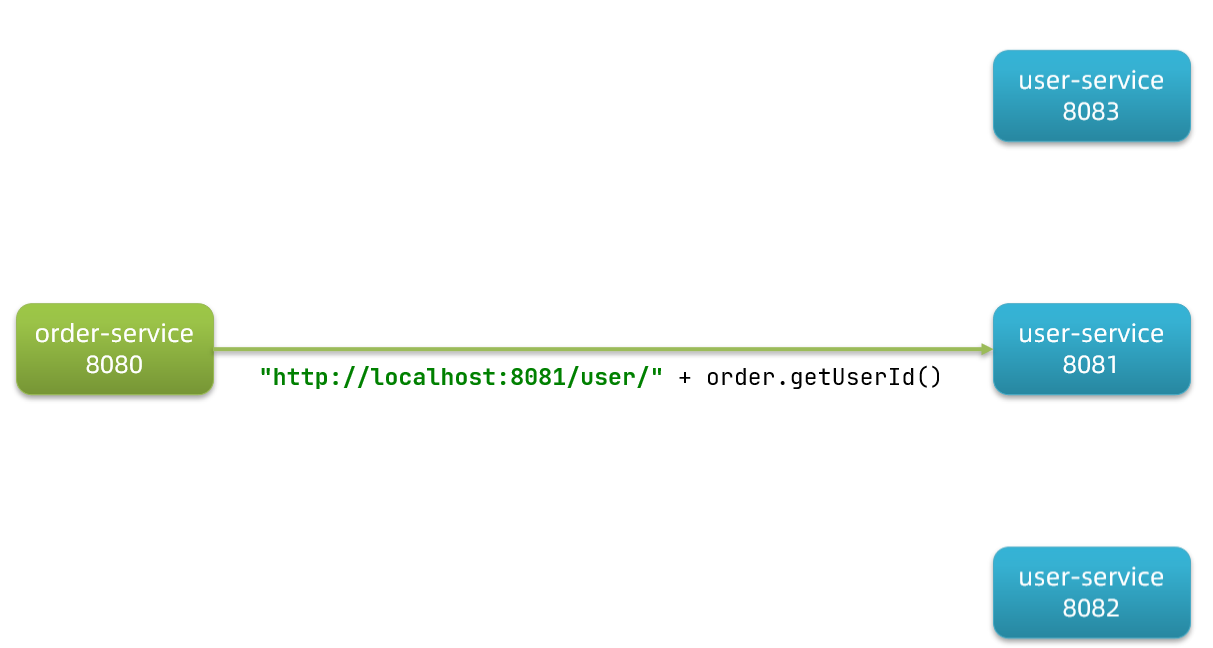

假如我们的服务提供者user-service部署了多个实例,如图:

3.1.Eureka的结构和作用

这些问题都需要利用SpringCloud中的注册中心来解决,其中最广为人知的注册中心就是Eureka,其结构如下:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-a3suA6Zv-1662516079572)(https://an-menghe.gitee.io/imgs/202203010024704.png)]

回答之前的各个问题。

问题1:order-service如何得知user-service实例地址?

获取地址信息的流程如下:

user-service服务实例启动后,将自己的信息注册到eureka-server(Eureka服务端)。这个叫服务注册

eureka-server保存服务名称到服务实例地址列表的映射关系

order-service根据服务名称,拉取实例地址列表。这个叫服务发现或服务拉取

问题2:order-service如何从多个user-service实例中选择具体的实例?

order-service从实例列表中利用负载均衡算法选中一个实例地址

向该实例地址发起远程调用

问题3:order-service如何得知某个user-service实例是否依然健康,是不是已经宕机?

user-service会每隔一段时间(默认30秒)向eureka-server发起请求,报告自己状态,称为心跳

当超过一定时间没有发送心跳时,eureka-server会认为微服务实例故障,将该实例从服务列表中剔除

order-service拉取服务时,就能将故障实例排除了

1 | package cn.itcast.eureka; |

1 | server: |

3.3.服务注册

下面,我们将user-service注册到eureka-server中去。

1)引入依赖

在user-service的pom文件中,引入下面的eureka-client依赖:

1 | <dependency> |

2)配置文件

在user-service中,修改application.yml文件,添加服务名称、eureka地址:

1 | spring: |

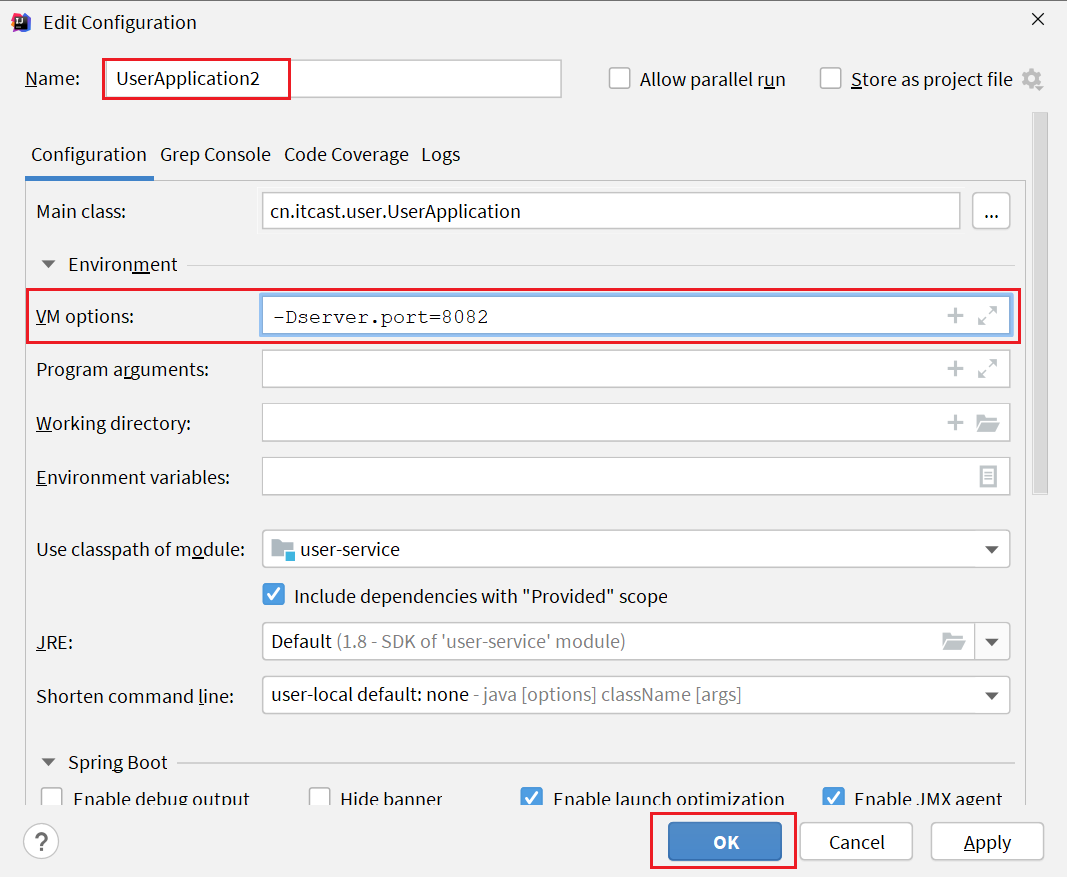

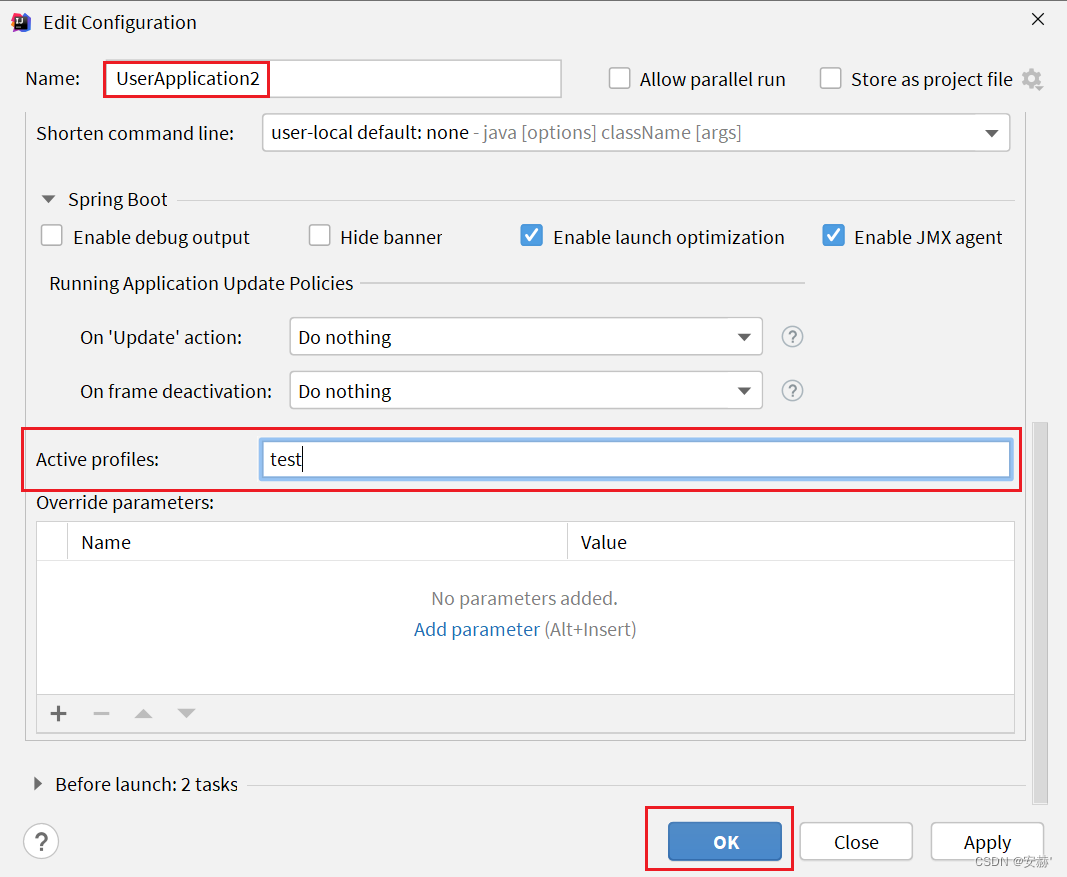

3)启动多个user-service实例

为了演示一个服务有多个实例的场景,我们添加一个SpringBoot的启动配置,再启动一个user-service。

首先,复制原来的user-service启动配置:

然后,在弹出的窗口中,填写信息:

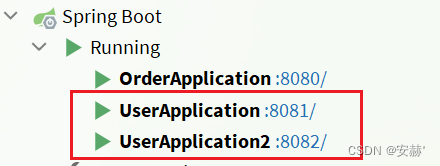

现在,SpringBoot窗口会出现两个user-service启动配置:

不过,第一个是8081端口,第二个是8082端口。

启动两个user-service实例:

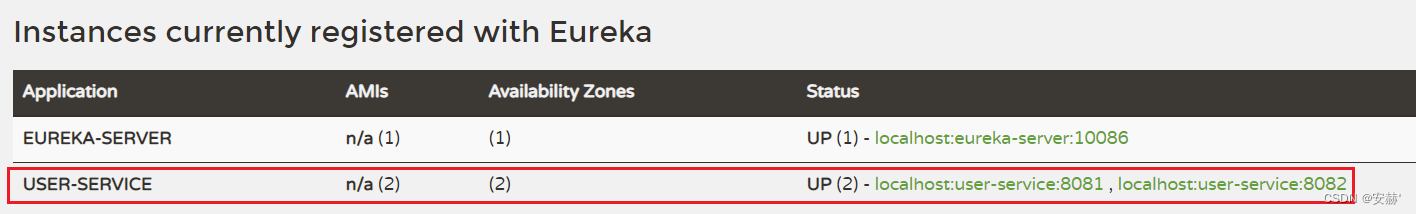

查看eureka-server管理页面:

3.4.服务发现

下面,我们将order-service的逻辑修改:向eureka-server拉取user-service的信息,实现服务发现。

1)引入依赖

之前说过,服务发现、服务注册统一都封装在eureka-client依赖,因此这一步与服务注册时一致。

在order-service的pom文件中,引入下面的eureka-client依赖:

1 | <dependency> |

2)配置文件

服务发现也需要知道eureka地址,因此第二步与服务注册一致,都是配置eureka信息:

在order-service中,修改application.yml文件,添加服务名称、eureka地址:

1 | spring: |

3)服务拉取和负载均衡

最后,我们要去eureka-server中拉取user-service服务的实例列表,并且实现负载均衡。

不过这些动作不用我们去做,只需要添加一些注解即可。

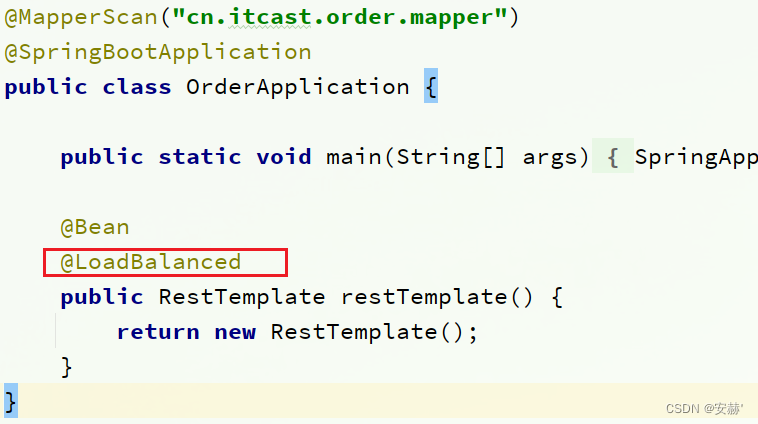

在order-service的OrderApplication中,给RestTemplate这个Bean添加一个@LoadBalanced注解:

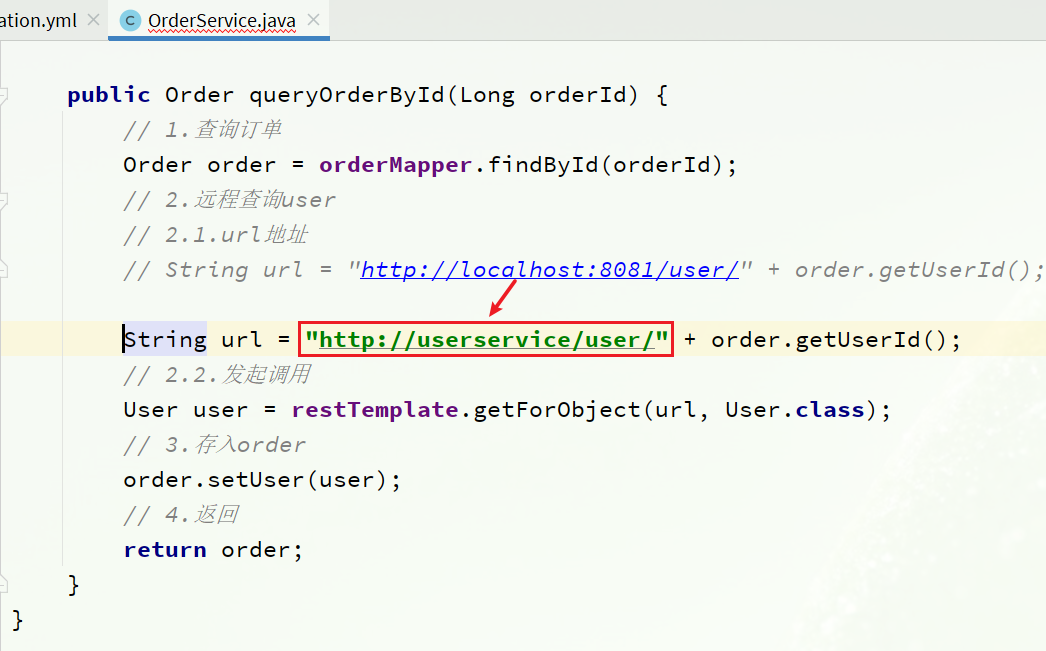

修改order-service服务中的cn.itcast.order.service包下的OrderService类中的queryOrderById方法。修改访问的url路径,用服务名代替ip、端口:

4.Ribbon负载均衡

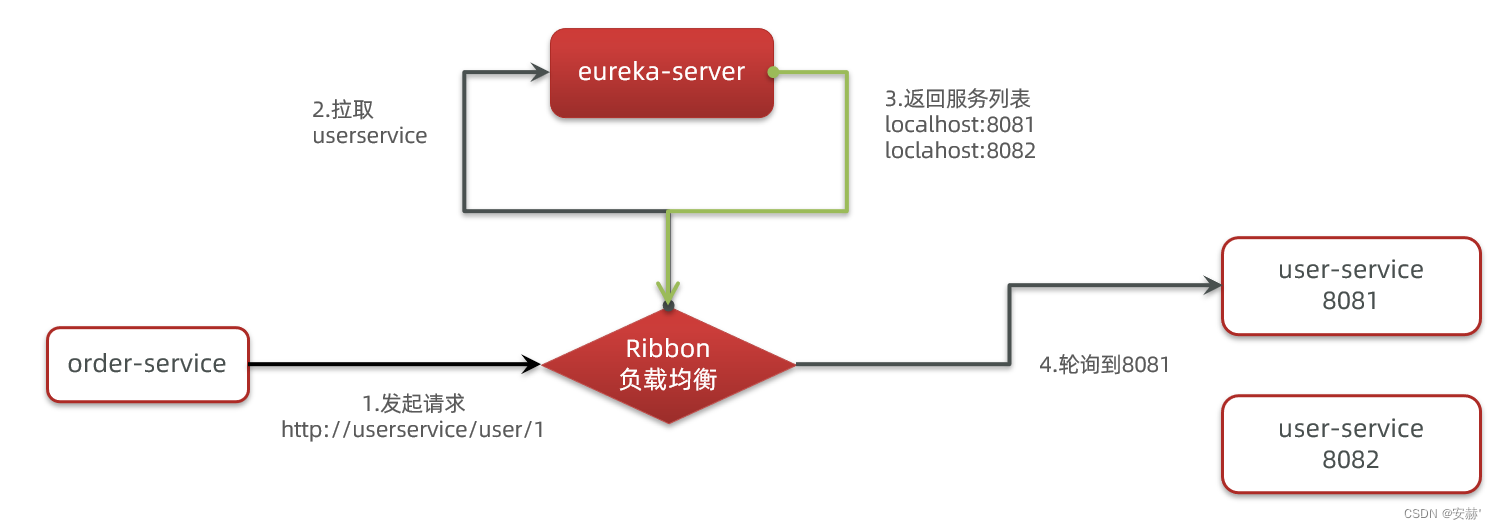

上一节中,我们添加了@LoadBalanced注解,即可实现负载均衡功能,这是什么原理呢?

4.1.负载均衡原理

SpringCloud底层其实是利用了一个名为Ribbon的组件,来实现负载均衡功能的。

那么我们发出的请求明明是http://userservice/user/1,怎么变成了http://localhost:8081的呢?

可以看到这里的intercept方法,拦截了用户的HttpRequest请求,然后做了几件事:

request.getURI():获取请求uri,本例中就是 http://user-service/user/8

originalUri.getHost():获取uri路径的主机名,其实就是服务id,user-service

this.loadBalancer.execute():处理服务id,和用户请求。

这里的this.loadBalancer是LoadBalancerClient类型,我们继续跟入。

4)总结

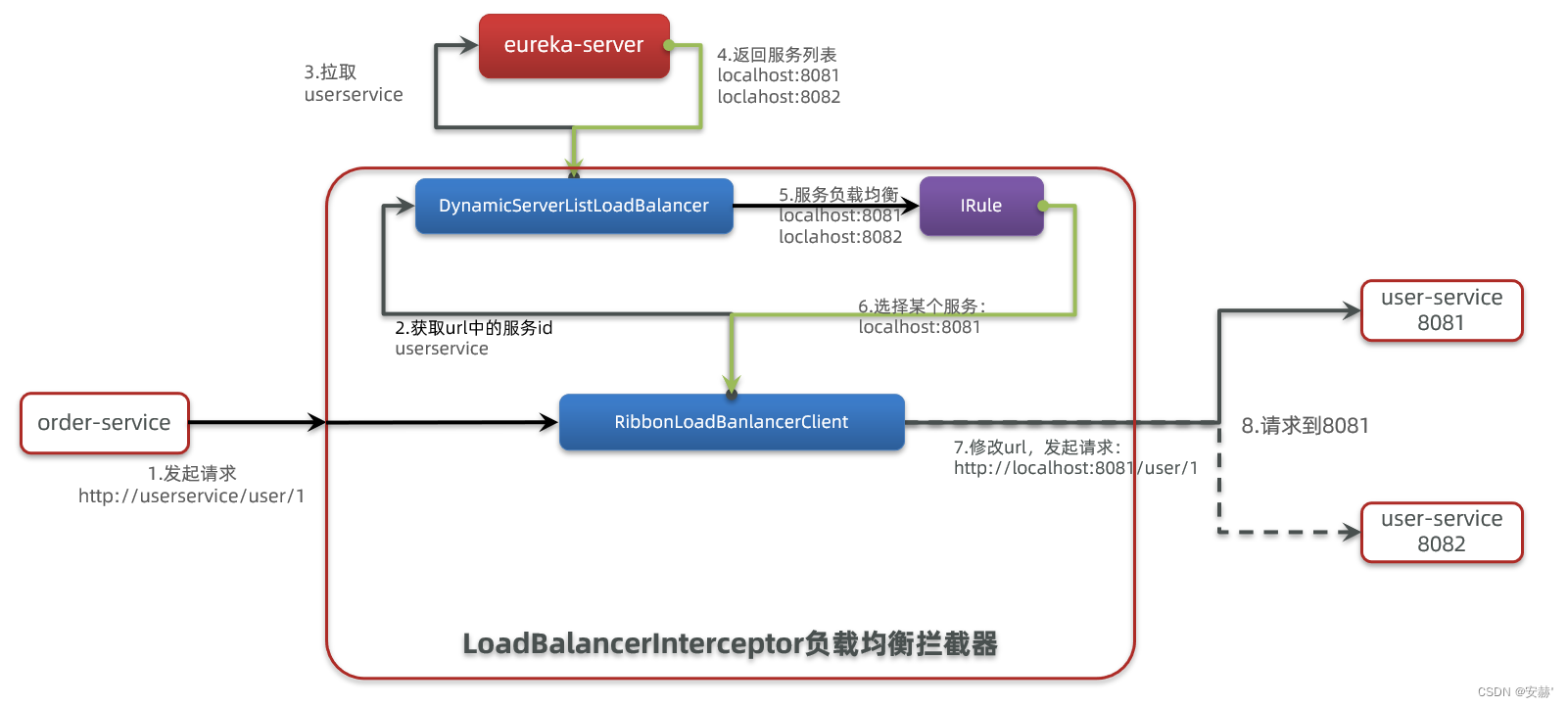

SpringCloudRibbon的底层采用了一个拦截器,拦截了RestTemplate发出的请求,对地址做了修改。用一幅图来总结一下:

基本流程如下:

拦截我们的RestTemplate请求http://userservice/user/1

RibbonLoadBalancerClient会从请求url中获取服务名称,也就是user-service

DynamicServerListLoadBalancer根据user-service到eureka拉取服务列表

eureka返回列表,localhost:8081、localhost:8082

IRule利用内置负载均衡规则,从列表中选择一个,例如localhost:8081

RibbonLoadBalancerClient修改请求地址,用localhost:8081替代userservice,得到http://localhost:8081/user/1,发起真实请求4.3.负载均衡策略

4.3.负载均衡策略

4.3.1.负载均衡策略

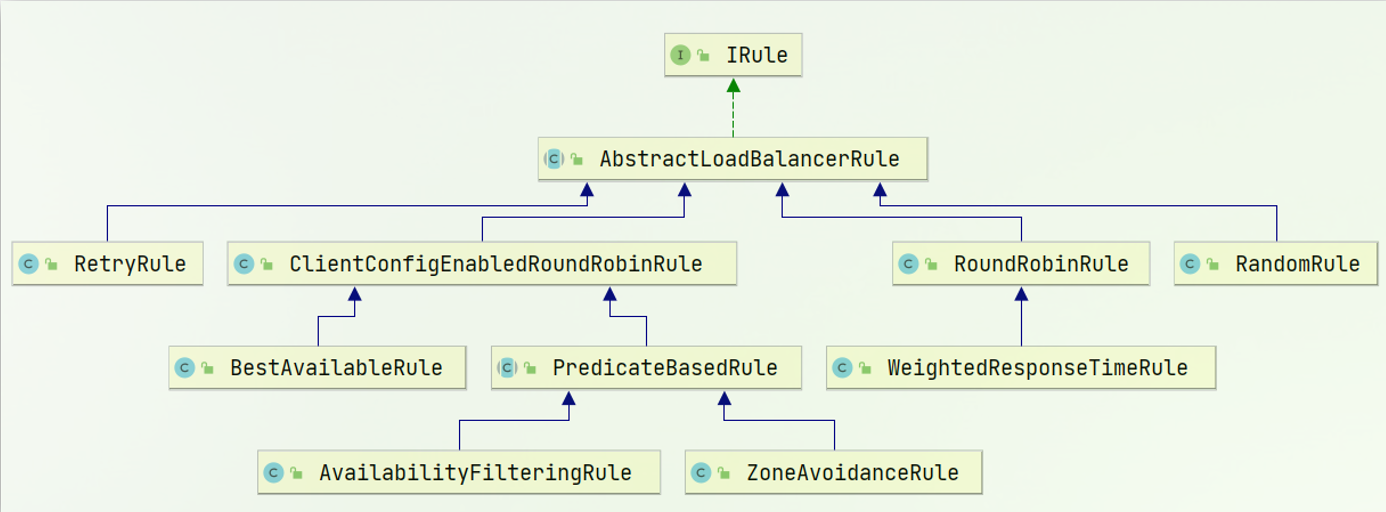

负载均衡的规则都定义在IRule接口中,而IRule有很多不同的实现类:

4.3.2.自定义负载均衡策略

通过定义IRule实现可以修改负载均衡规则,有两种方式:

代码方式:在order-service中的OrderApplication类中,定义一个新的IRule:

1 |

|

配置文件方式:在order-service的application.yml文件中,添加新的配置也可以修改规则:

1 | userservice: # 给某个微服务配置负载均衡规则,这里是userservice服务 |

注意,一般用默认的负载均衡规则,不做修改。

4.4.饥饿加载

Ribbon默认是采用懒加载,即第一次访问时才会去创建LoadBalanceClient,请求时间会很长。

而饥饿加载则会在项目启动时创建,降低第一次访问的耗时,通过下面配置开启饥饿加载:

1 | ribbon: |

5.Nacos注册中心

5.2.服务注册到nacos

Nacos是SpringCloudAlibaba的组件,而SpringCloudAlibaba也遵循SpringCloud中定义的服务注册、服务发现规范。因此使用Nacos和使用Eureka对于微服务来说,并没有太大区别。

主要差异在于:

依赖不同

服务地址不同

1)引入依赖

在cloud-demo父工程的pom文件中的

1 | <dependency> |

然后在user-service和order-service中的pom文件中引入nacos-discovery依赖:

1 | <dependency> |

2)配置nacos地址

在user-service和order-service的application.yml中添加nacos地址:

1 | spring: |

5.3.服务分级存储模型

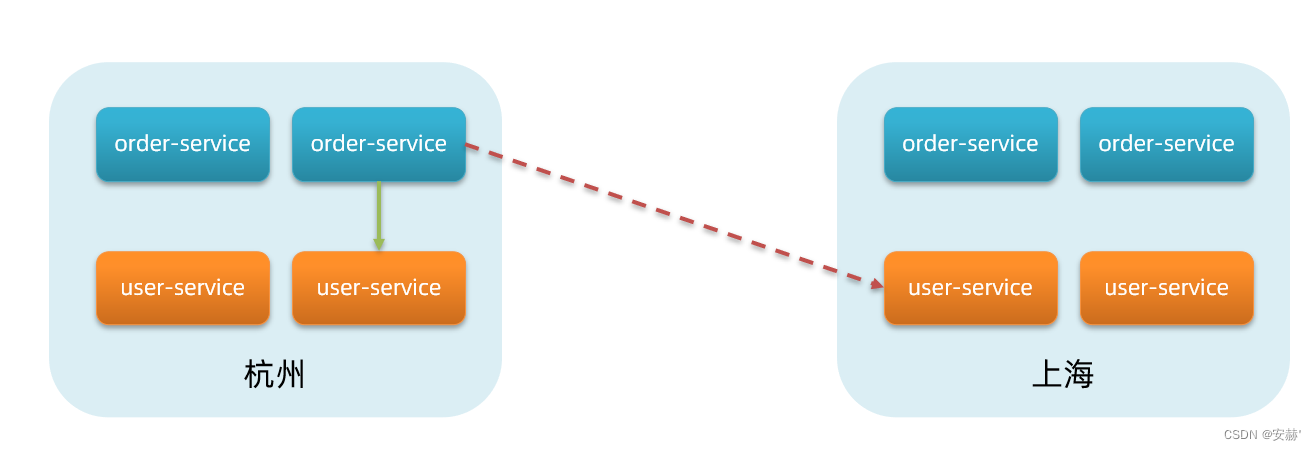

微服务互相访问时,应该尽可能访问同集群实例,因为本地访问速度更快。当本集群内不可用时,才访问其它集群。例如:

杭州机房内的order-service应该优先访问同机房的user-service。

5.3.1.给user-service配置集群

修改user-service的application.yml文件,添加集群配置:

1 | spring: |

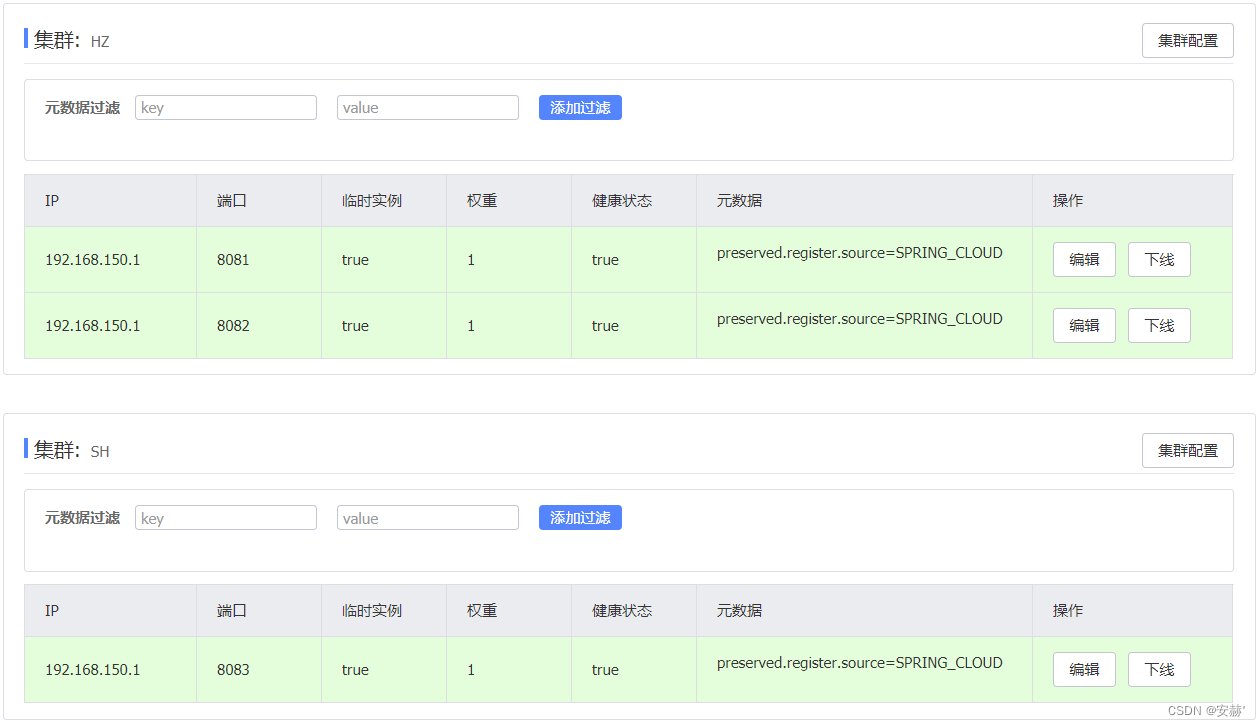

重启两个user-service实例后,我们可以在nacos控制台看到下面结果:

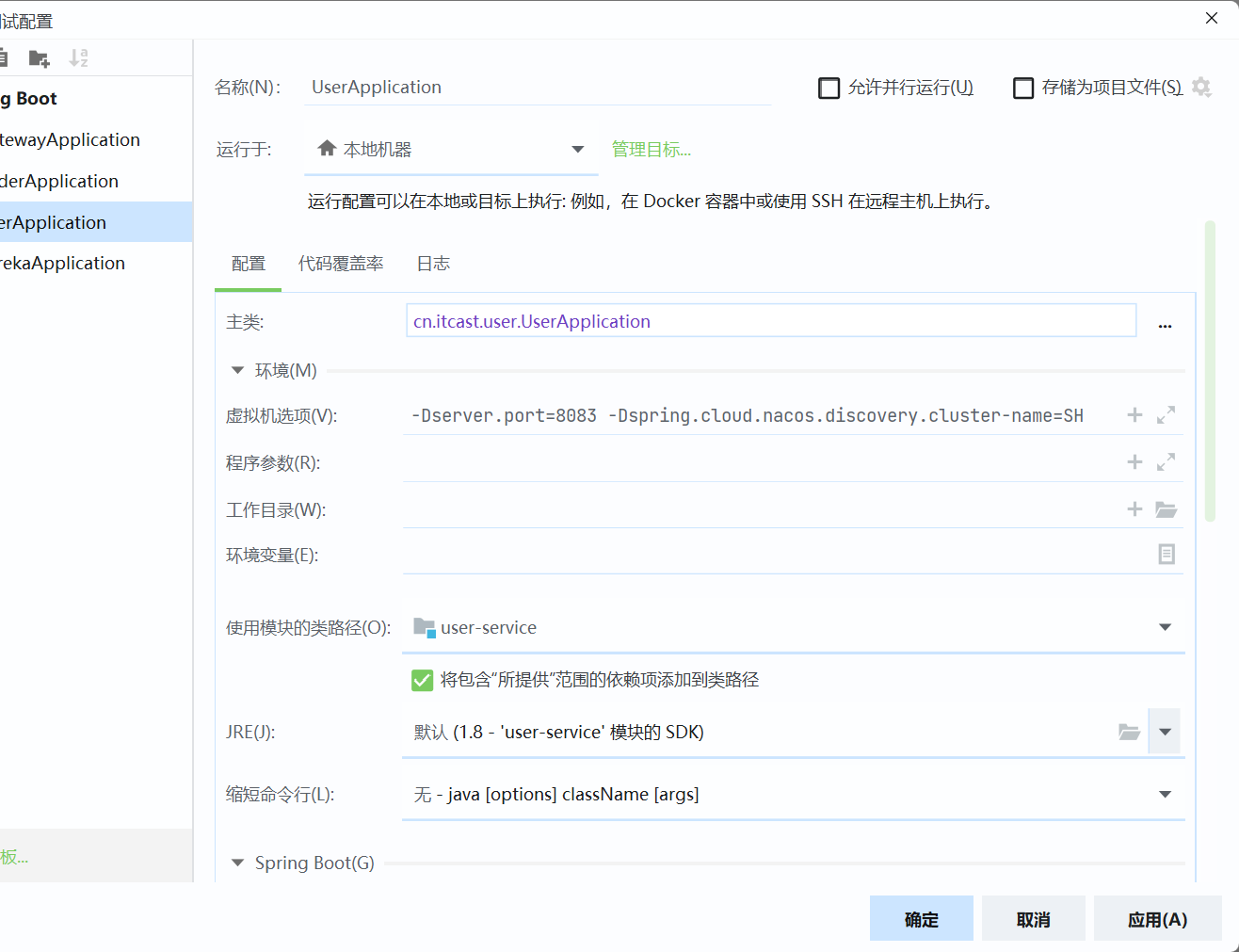

我们再次复制一个user-service启动配置,添加属性:

-Dserver.port=8083 -Dspring.cloud.nacos.discovery.cluster-name=SH

1

启动UserApplication3后再次查看nacos控制台:

5.3.2.同集群优先的负载均衡

认的ZoneAvoidanceRule并不能实现根据同集群优先来实现负载均衡。

因此Nacos中提供了一个NacosRule的实现,可以优先从同集群中挑选实例。

1)给order-service配置集群信息

修改order-service的application.yml文件,添加集群配置:

1 | spring: |

2)修改负载均衡规则

修改order-service的application.yml文件,修改负载均衡规则:

1 | userservice: |

5.4.权重配置

实际部署中会出现这样的场景:

服务器设备性能有差异,部分实例所在机器性能较好,另一些较差,我们希望性能好的机器承担更多的用户请求。

但默认情况下NacosRule是同集群内随机挑选,不会考虑机器的性能问题。

因此,Nacos提供了权重配置来控制访问频率,权重越大则访问频率越高。

在nacos控制台,找到user-service的实例列表,点击编辑,即可修改权重:

5.5.环境隔离

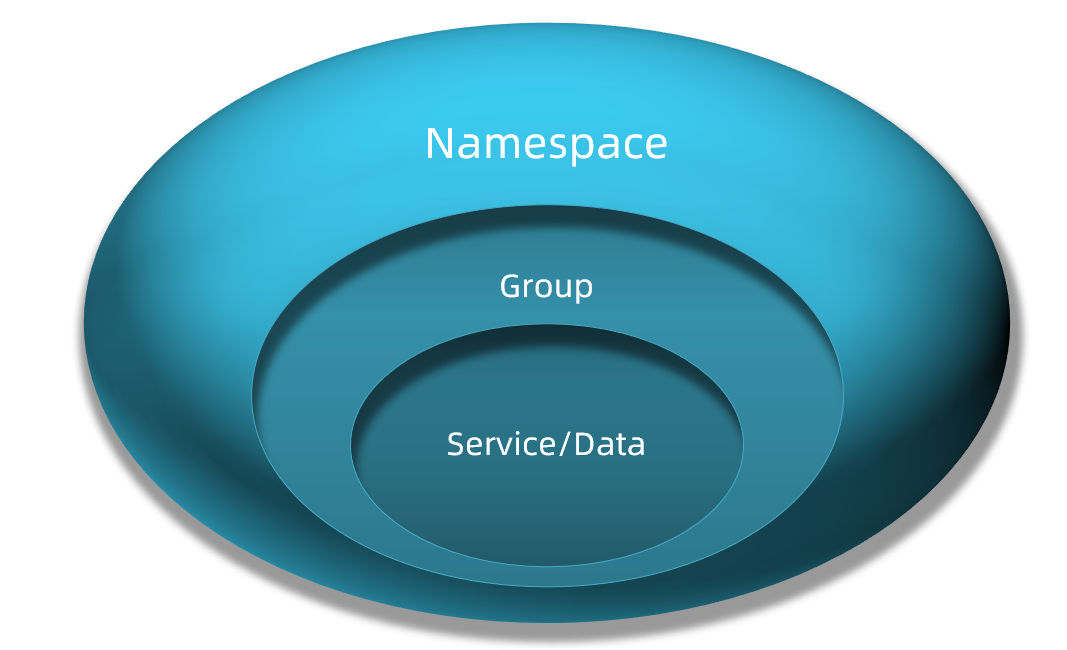

Nacos提供了namespace来实现环境隔离功能。

- nacos中可以有多个namespace

- namespace下可以有group、service等

- 不同namespace之间相互隔离,例如不同namespace的服务互相不可见

5.5.2.给微服务配置namespace

给微服务配置namespace只能通过修改配置来实现。

例如,修改order-service的application.yml文件:

1 | spring: |

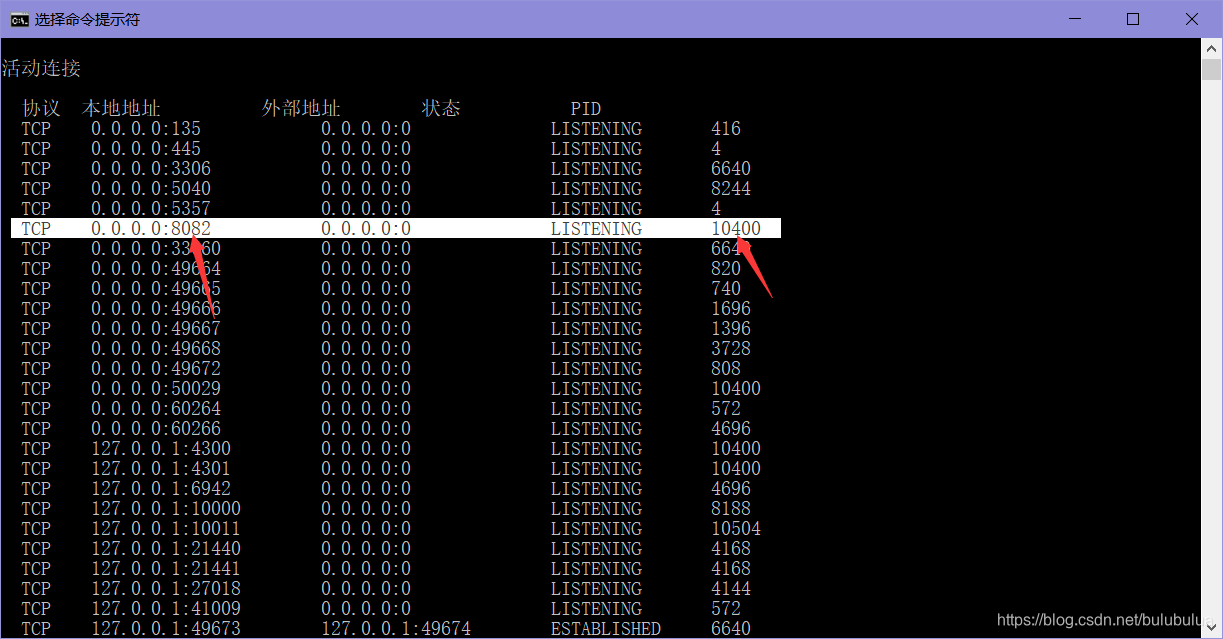

PS:遇到的bug

端口8082被占用了。

原因可能如下:

1电脑中其他进程占用8080端口;

2其他Spring Boot项目占用8080端口;

3自己要运行的项目重复生成占用了端口。

解决方法:

打开cmd,输入如下命令,查找8082端口对应的进程ID PID:

1 | netstat -ano |

这里PID为10400,再输入如下命令杀死进程:

1 | taskkill /F /pid 10400 |

6.Nacos配置管理

Nacos除了可以做注册中心,同样可以做配置管理来使用。

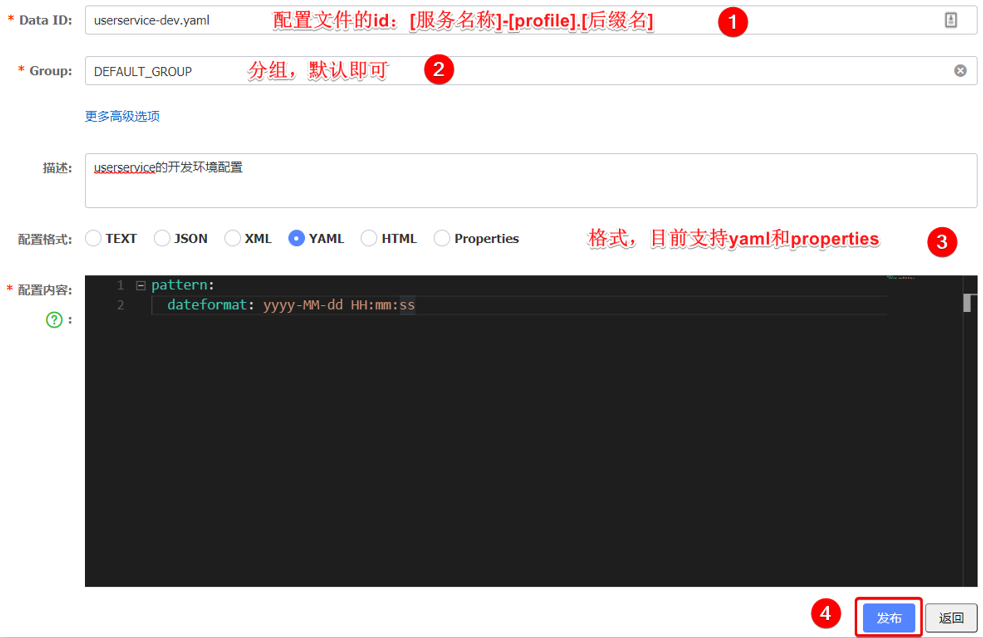

如何在nacos中管理配置呢?

6.1.统一配置管理

然后在弹出的表单中,填写配置信息:

注意:项目的核心配置,需要热更新的配置才有放到nacos管理的必要。基本不会变更的一些配置还是保存在微服务本地比较好。

6.1.2.从微服务拉取配置

微服务要拉取nacos中管理的配置,并且与本地的application.yml配置合并,才能完成项目启动。

但如果尚未读取application.yml,又如何得知nacos地址呢?

因此spring引入了一种新的配置文件:bootstrap.yaml文件,会在application.yml之前被读取,流程如下:

1)引入nacos-config依赖

首先,在user-service服务中,引入nacos-config的客户端依赖:

1 | <!--nacos配置管理依赖--> |

2)添加bootstrap.yaml

然后,在user-service中添加一个bootstrap.yaml文件,内容如下:

1 | spring: |

这里会根据spring.cloud.nacos.server-addr获取nacos地址,再根据

s p r i n g . a p p l i c a t i o n . n a m e − {spring.application.name}-spring.application.name−{spring.profiles.active}.${spring.cloud.nacos.config.file-extension}作为文件id,来读取配置。

本例中,就是去读取userservice-dev.yaml:

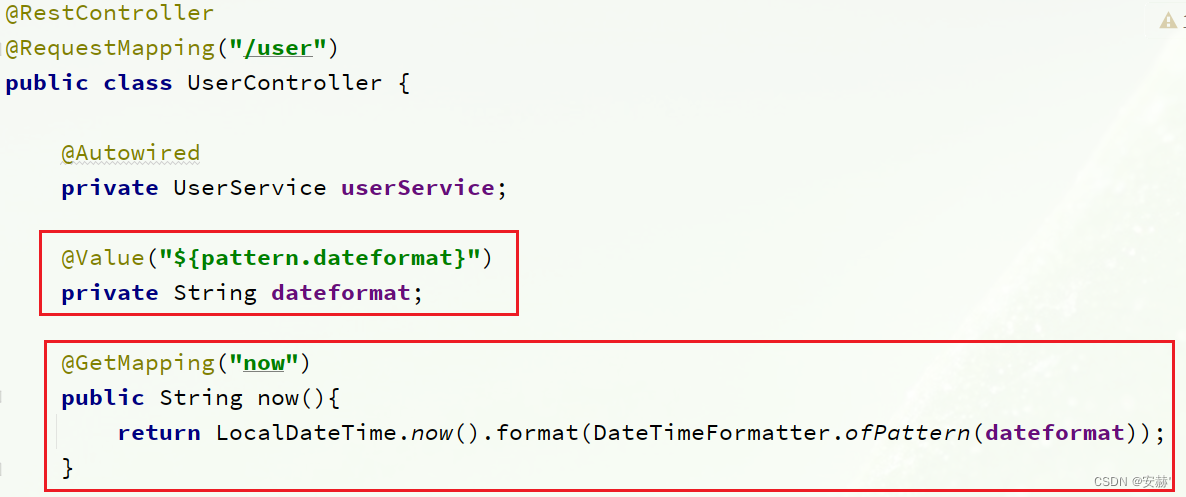

6.2.配置热更新

我们最终的目的,是修改nacos中的配置后,微服务中无需重启即可让配置生效,也就是配置热更新。

要实现配置热更新,可以使用两种方式:

6.2.1.方式一

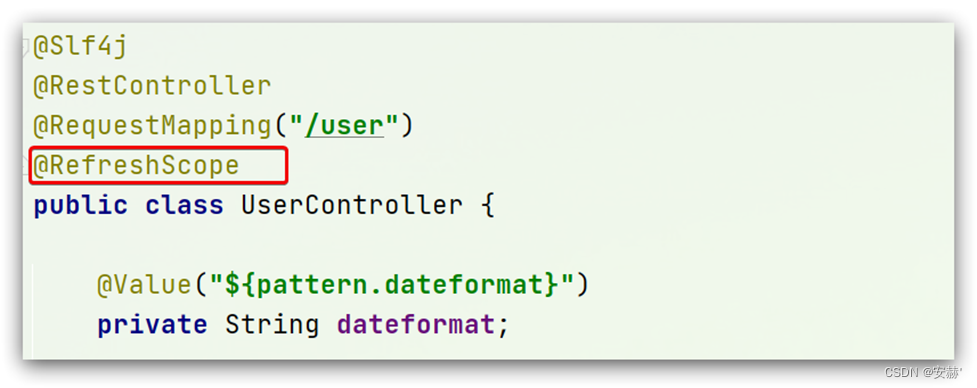

在@Value注入的变量所在类上添加注解@RefreshScope:

6.2.2.方式二

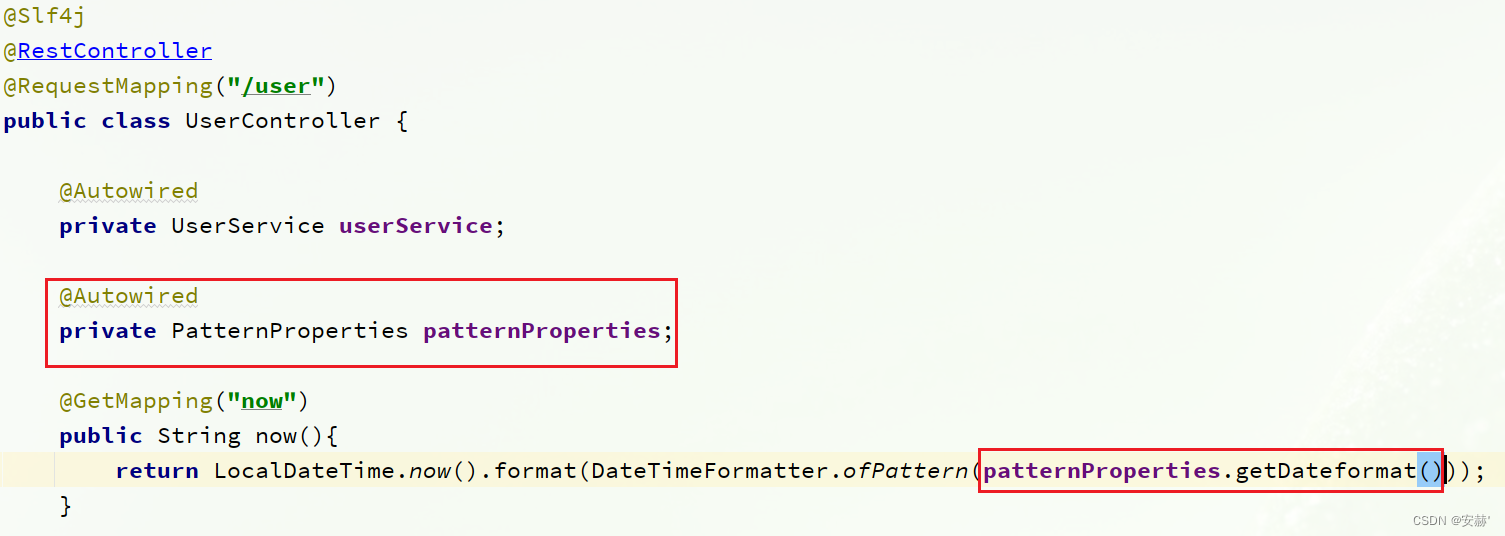

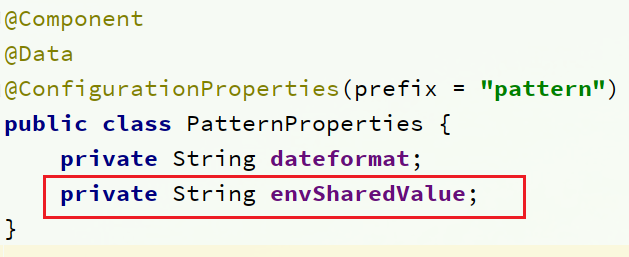

使用@ConfigurationProperties注解代替@Value注解。

在user-service服务中,添加一个类,读取patterrn.dateformat属性:

1 | package cn.itcast.user.config; |

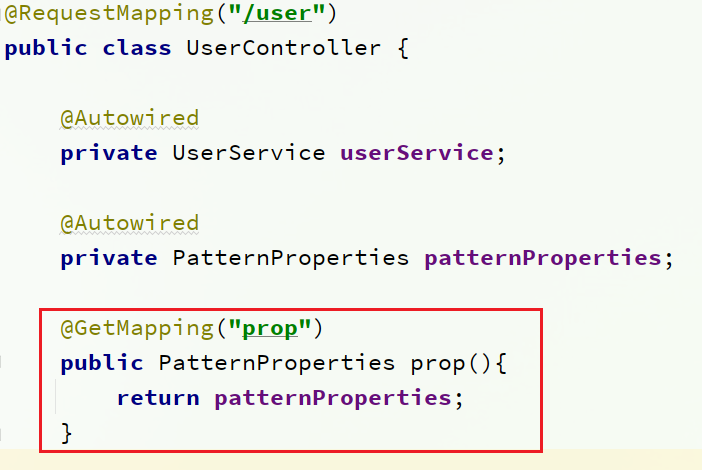

在UserController中使用这个类代替@Value:

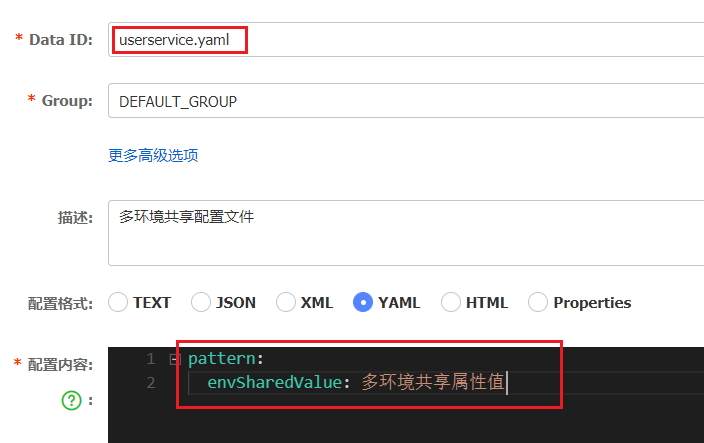

6.3.配置共享

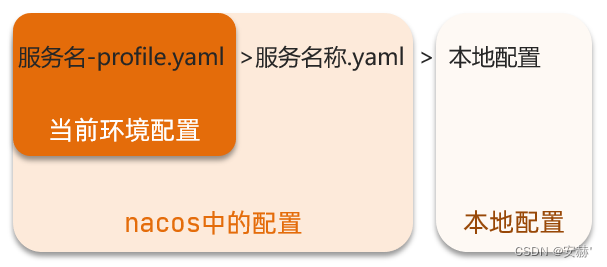

其实微服务启动时,会去nacos读取多个配置文件,例如:

[spring.application.name]-[spring.profiles.active].yaml,例如:userservice-dev.yaml

[spring.application.name].yaml,例如:userservice.yaml而[spring.application.name].yaml不包含环境,因此可以被多个环境共享。

下面我们通过案例来测试配置共享

2)在user-service中读取共享配置

在user-service服务中,修改PatternProperties类,读取新添加的属性:

这样,UserApplication(8081)使用的profile是dev,UserApplication2(8082)使用的profile是test。

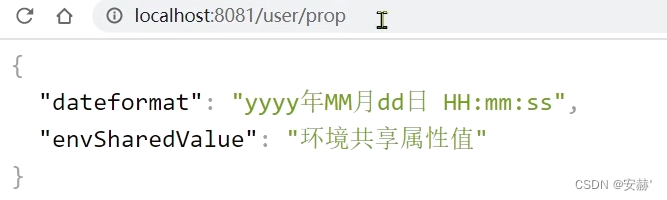

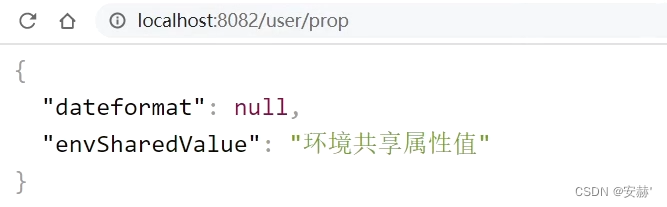

启动UserApplication和UserApplication2

访问http://localhost:8081/user/prop,结果:

访问http://localhost:8082/user/prop,结果:

可以看出来,不管是dev,还是test环境,都读取到了envSharedValue这个属性的值。

4)配置共享的优先级

当nacos、服务本地同时出现相同属性时,优先级有高低之分:

6.4.搭建Nacos集群

Nacos生产环境下一定要部署为集群状态,部署方式参考课前资料中的文档:

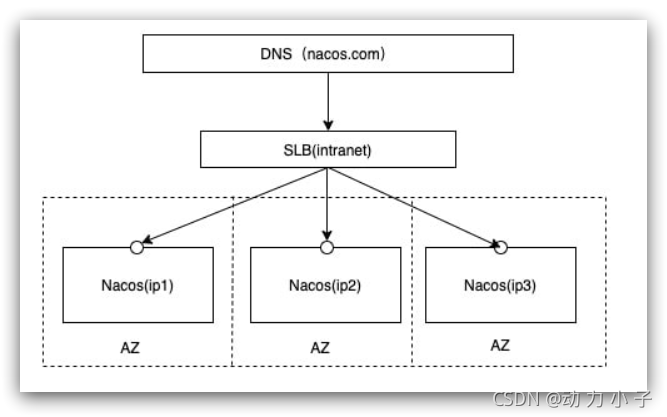

1.集群结构图

官方给出的Nacos集群图:

其中包含3个nacos节点,然后一个负载均衡器代理3个Nacos。这里负载均衡器可以使用nginx。

我们计划的集群结构:

三个nacos节点的地址:

| 节点 | ip | port |

|---|---|---|

| nacos1 | 192.168.150.1 | 8845 |

| nacos2 | 192.168.150.1 | 8846 |

| nacos3 | 192.168.150.1 | 8847 |

2.搭建集群

搭建集群的基本步骤:

- 搭建数据库,初始化数据库表结构

- 下载nacos安装包

- 配置nacos

- 启动nacos集群

- nginx反向代理

2.1.初始化数据库

Nacos默认数据存储在内嵌数据库Derby中,不属于生产可用的数据库。

官方推荐的最佳实践是使用带有主从的高可用数据库集群,主从模式的高可用数据库可以参考传智教育的后续高手课程。

这里我们以单点的数据库为例来讲解。

首先新建一个数据库,命名为nacos,而后导入下面的SQL:

1 | CREATE TABLE `config_info` ( |

2.2.下载nacos

nacos在GitHub上有下载地址:https://github.com/alibaba/nacos/tags,可以选择任意版本下载。

本例中才用1.4.1版本:

2.3.配置Nacos

将这个包解压到任意非中文目录下,如图:

目录说明:

- bin:启动脚本

- conf:配置文件

进入nacos的conf目录,修改配置文件cluster.conf.example,重命名为cluster.conf:

然后添加内容:

1 | 127.0.0.1:8845 |

然后修改application.properties文件,添加数据库配置

1 | spring.datasource.platform=mysql |

2.4.启动

将nacos文件夹复制三份,分别命名为:nacos1、nacos2、nacos3

然后分别修改三个文件夹中的application.properties,

nacos1:

1 | server.port=8845 |

nacos2:

1 | server.port=8846 |

nacos3:

1 | server.port=8847 |

然后分别启动三个nacos节点:

1 | startup.cmd |

2.5.nginx反向代理

找到课前资料提供的nginx安装包:

解压到任意非中文目录下:

修改conf/nginx.conf文件,配置如下:

1 | upstream nacos-cluster { |

而后在浏览器访问:http://localhost/nacos即可。

代码中application.yml文件配置如下:

1 | spring: |

2.6.优化

- 实际部署时,需要给做反向代理的nginx服务器设置一个域名,这样后续如果有服务器迁移nacos的客户端也无需更改配置.

- Nacos的各个节点应该部署到多个不同服务器,做好容灾和隔离

7.Feign远程调用

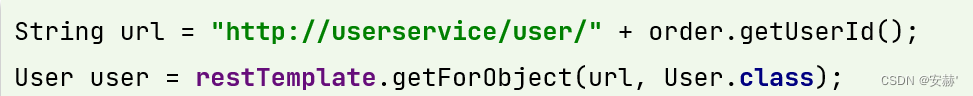

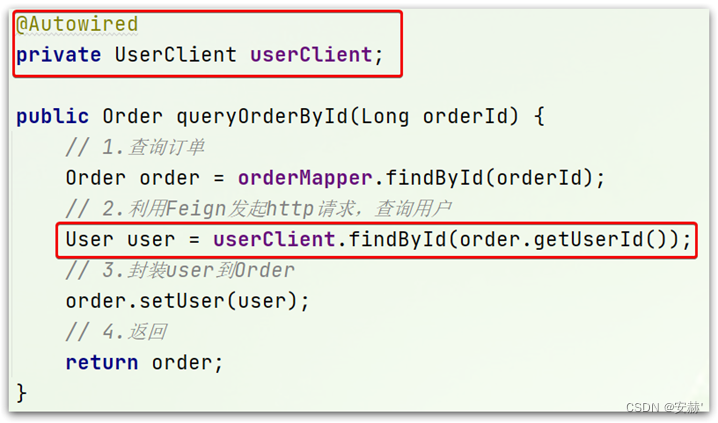

先来看我们以前利用RestTemplate发起远程调用的代码:

7.1.Feign替代RestTemplate

Fegin的使用步骤如下:

1)引入依赖

我们在order-service服务的pom文件中引入feign的依赖:

1 | <dependency> |

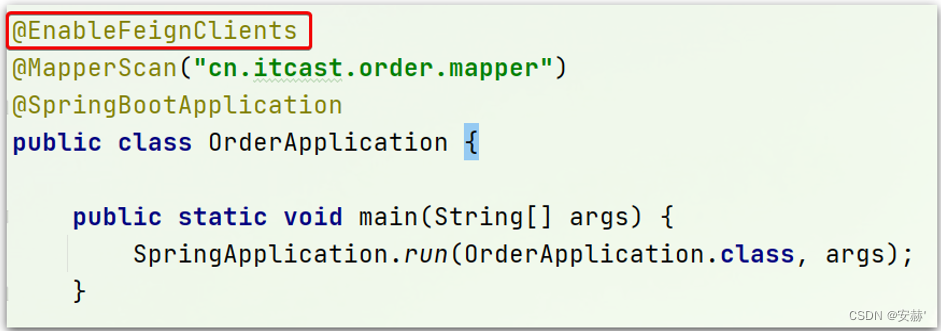

2)添加注解

在order-service的启动类添加注解开启Feign的功能:

3)编写Feign的客户端

在order-service中新建一个接口,内容如下:

1 | package cn.itcast.order.client; |

4)测试

修改order-service中的OrderService类中的queryOrderById方法,使用Feign客户端代替RestTemplate:

是不是看起来优雅多了。

5)总结

使用Feign的步骤:

① 引入依赖

② 添加@EnableFeignClients注解

③ 编写FeignClient接口

④ 使用FeignClient中定义的方法代替RestTemplate

7.2.自定义配置

Feign可以支持很多的自定义配置,如下表所示:

类型 作用 说明

feign.Logger.Level 修改日志级别 包含四种不同的级别:NONE、BASIC、HEADERS、FULL

feign.codec.Decoder 响应结果的解析器 http远程调用的结果做解析,例如解析json字符串为java对象

feign.codec.Encoder 请求参数编码 将请求参数编码,便于通过http请求发送

feign. Contract 支持的注解格式 默认是SpringMVC的注解

feign. Retryer 失败重试机制 请求失败的重试机制,默认是没有,不过会使用Ribbon的重试

一般情况下,默认值就能满足我们使用,如果要自定义时,只需要创建自定义的@Bean覆盖默认Bean即可。

基于配置文件修改feign的日志级别可以针对单个服务:

1 | feign: |

也可以针对所有服务:

1 | feign: |

而日志的级别分为四种:

- NONE:不记录任何日志信息,这是默认值。

- BASIC:仅记录请求的方法,URL以及响应状态码和执行时间

- HEADERS:在BASIC的基础上,额外记录了请求和响应的头信息

- FULL:记录所有请求和响应的明细,包括头信息、请求体、元数据。

7.2.2.Java代码方式

也可以基于Java代码来修改日志级别,先声明一个类,然后声明一个Logger.Level的对象:

1 | public class DefaultFeignConfiguration { |

@EnableFeignClients(defaultConfiguration = DefaultFeignConfiguration .class)

1

如果是局部生效,则把它放到接口对应的@FeignClient这个注解中:

@FeignClient(value = “userservice”, configuration = DefaultFeignConfiguration .class)

1

7.3.Feign使用优化

Feign底层发起http请求,依赖于其它的框架。其底层客户端实现包括:

•URLConnection:默认实现,不支持连接池

•Apache HttpClient :支持连接池

•OKHttp:支持连接池

因此提高Feign的性能主要手段就是使用连接池代替默认的URLConnection。

这里我们用Apache的HttpClient来演示。

1)引入依赖

在order-service的pom文件中引入Apache的HttpClient依赖:

1 | <dependency> |

2)配置连接池

在order-service的application.yml中添加配置:

1 | feign: |

总结,Feign的优化:

1.日志级别尽量用basic

2.使用HttpClient或OKHttp代替URLConnection

① 引入feign-httpClient依赖

② 配置文件开启httpClient功能,设置连接池参数

7.4.最佳实践

所谓最近实践,就是使用过程中总结的经验,最好的一种使用方式。

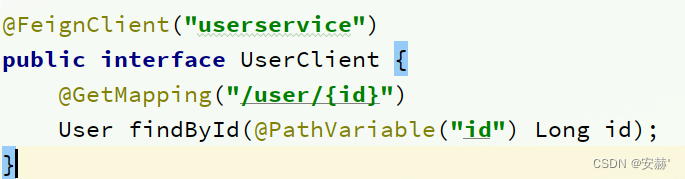

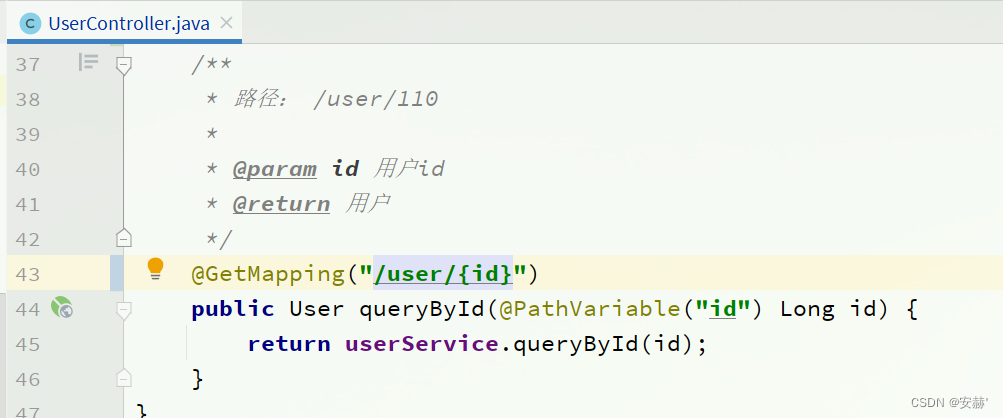

自习观察可以发现,Feign的客户端与服务提供者的controller代码非常相似:

feign客户端:

UserController:

有没有一种办法简化这种重复的代码编写呢?

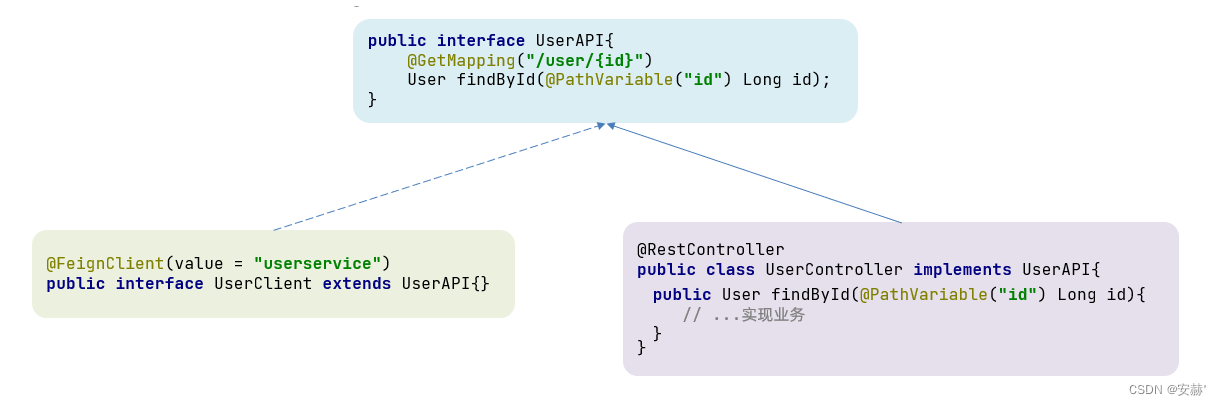

7.4.1.继承方式

一样的代码可以通过继承来共享:

1)定义一个API接口,利用定义方法,并基于SpringMVC注解做声明。

2)Feign客户端和Controller都集成改接口

优点:

- 简单

- 实现了代码共享

缺点:

- 服务提供方、服务消费方紧耦合

- 参数列表中的注解映射并不会继承,因此Controller中必须再次声明方法、参数列表、注解

7.4.2.抽取方式

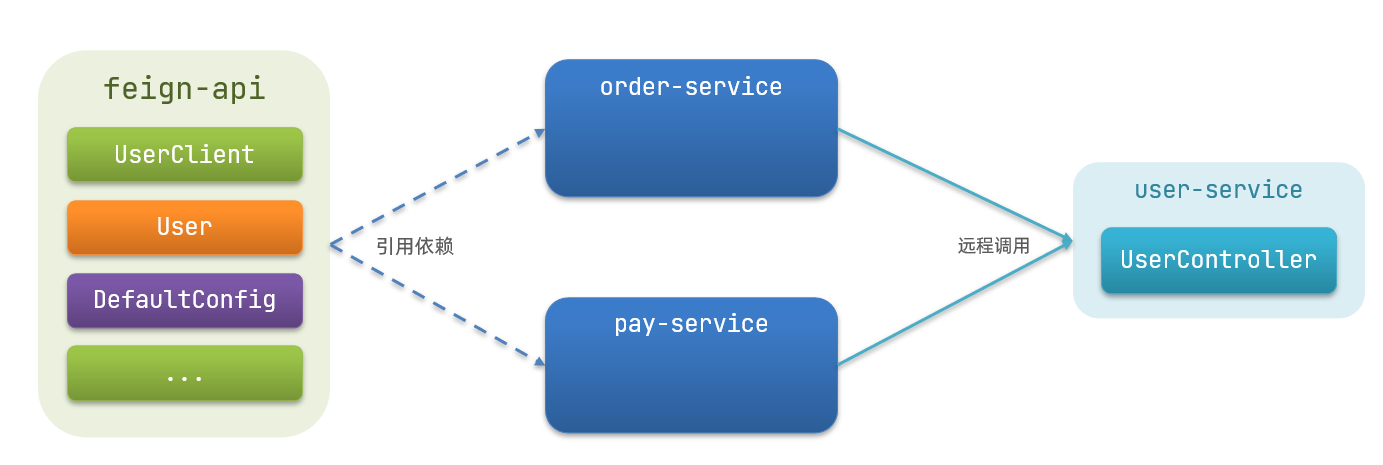

将Feign的Client抽取为独立模块,并且把接口有关的POJO、默认的Feign配置都放到这个模块中,提供给所有消费者使用。

例如,将UserClient、User、Feign的默认配置都抽取到一个feign-api包中,所有微服务引用该依赖包,即可直接使用。

7.4.3.实现基于抽取的最佳实践

1)抽取

首先创建一个module,命名为feign-api:

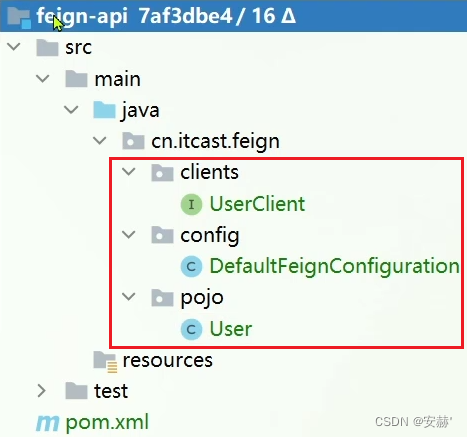

项目结构:

在feign-api中然后引入feign的starter依赖

1 | <dependency> |

然后,order-service中编写的UserClient、User、DefaultFeignConfiguration都复制到feign-api项目中

2)在order-service中使用feign-api

首先,删除order-service中的UserClient、User、DefaultFeignConfiguration等类或接口。

在order-service的pom文件中中引入feign-api的依赖:

1 | <dependency> |

修改order-service中的所有与上述三个组件有关的导包部分,改成导入feign-api中的包

3)重启测试

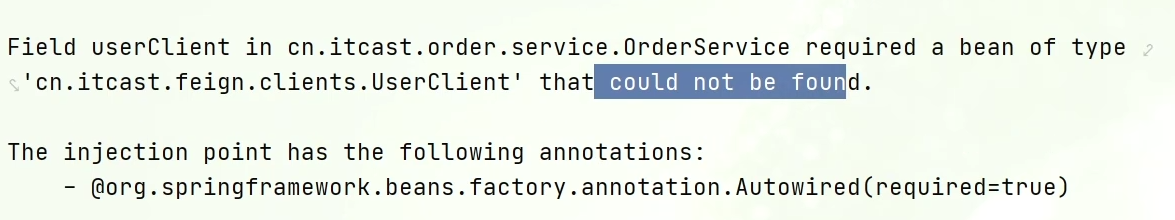

重启后,发现服务报错了:

这是因为UserClient现在在cn.itcast.feign.clients包下,

而order-service的@EnableFeignClients注解是在cn.itcast.order包下,不在同一个包,无法扫描到UserClient。

4)解决扫描包问题

方式一:

指定Feign应该扫描的包:

1 |

方式二:

指定需要加载的Client接口:

1 |

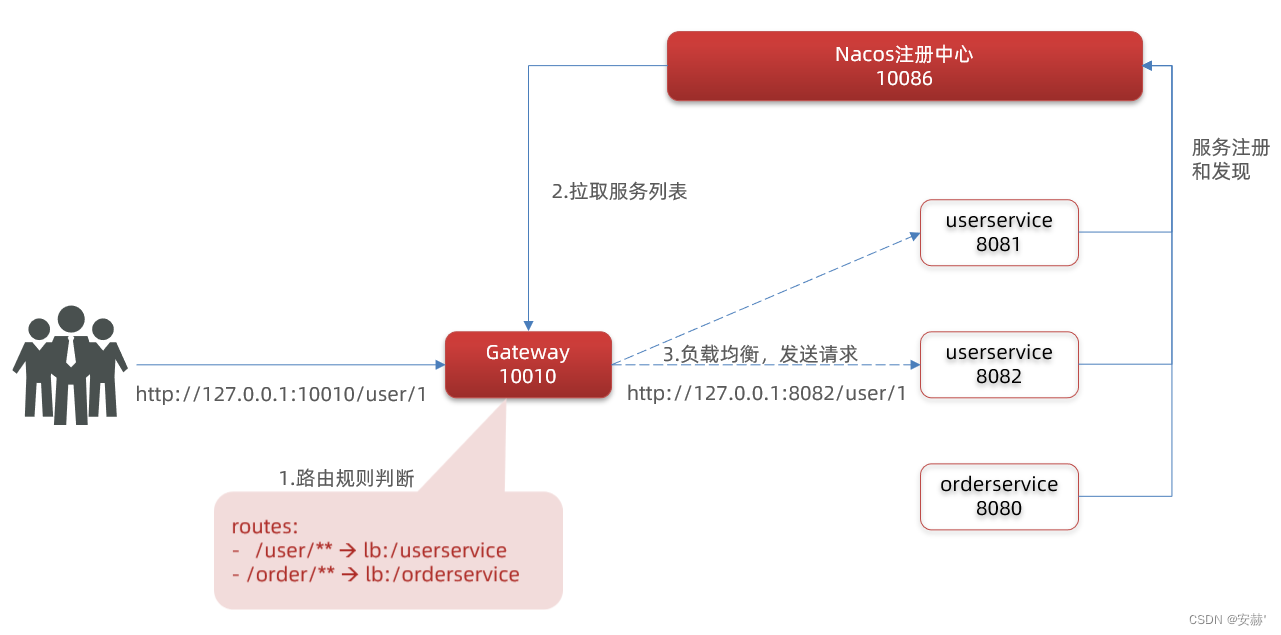

8.Gateway服务网关

Spring Cloud Gateway 是 Spring Cloud 的一个全新项目,该项目是基于 Spring 5.0,Spring Boot 2.0 和 Project Reactor 等响应式编程和事件流技术开发的网关,它旨在为微服务架构提供一种简单有效的统一的 API 路由管理方式。

8.1.为什么需要网关

Gateway网关是我们服务的守门神,所有微服务的统一入口。

网关的核心功能特性:

- 请求路由

- 权限控制

- 限流

权限控制:网关作为微服务入口,需要校验用户是是否有请求资格,如果没有则进行拦截。

路由和负载均衡:一切请求都必须先经过gateway,但网关不处理业务,而是根据某种规则,把请求转发到某个微服务,这个过程叫做路由。当然路由的目标服务有多个时,还需要做负载均衡。

限流:当请求流量过高时,在网关中按照下流的微服务能够接受的速度来放行请求,避免服务压力过大。

在SpringCloud中网关的实现包括两种:

gateway

zuul

Zuul是基于Servlet的实现,属于阻塞式编程。而SpringCloudGateway则是基于Spring5中提供的WebFlux,属于响应式编程的实现,具备更好的性能。

8.2.gateway快速入门

下面,我们就演示下网关的基本路由功能。基本步骤如下:

创建SpringBoot工程gateway,引入网关依赖

编写启动类

编写基础配置和路由规则

启动网关服务进行测试

1)创建gateway服务,引入依赖创建服务:

引入依赖:

1 | <!--网关--> |

1 | package cn.itcast.gateway; |

1 | server: |

我们将符合Path 规则的一切请求,都代理到 uri参数指定的地址。

本例中,我们将 /user/**开头的请求,代理到lb://userservice,lb是负载均衡,根据服务名拉取服务列表,实现负载均衡。

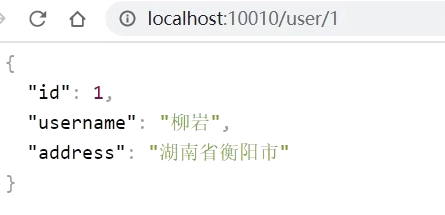

4)重启测试

重启网关,访问http://localhost:10010/user/1时,符合`/user/**`规则,请求转发到uri:http://userservice/user/1,得到了结果:

5)网关路由的流程图

整个访问的流程如下:

总结:网关搭建步骤:

创建项目,引入nacos服务发现和gateway依赖

配置application.yml,包括服务基本信息、nacos地址、路由

路由配置包括:

路由id:路由的唯一标示

路由目标(uri):路由的目标地址,http代表固定地址,lb代表根据服务名负载均衡

路由断言(predicates):判断路由的规则,

路由过滤器(filters):对请求或响应做处理

8.3.断言工厂

我们在配置文件中写的断言规则只是字符串,这些字符串会被Predicate Factory读取并处理,转变为路由判断的条件

例如Path=/user/**是按照路径匹配,这个规则是由

org.springframework.cloud.gateway.handler.predicate.PathRoutePredicateFactory类来

处理的,像这样的断言工厂在SpringCloudGateway还有十几个:

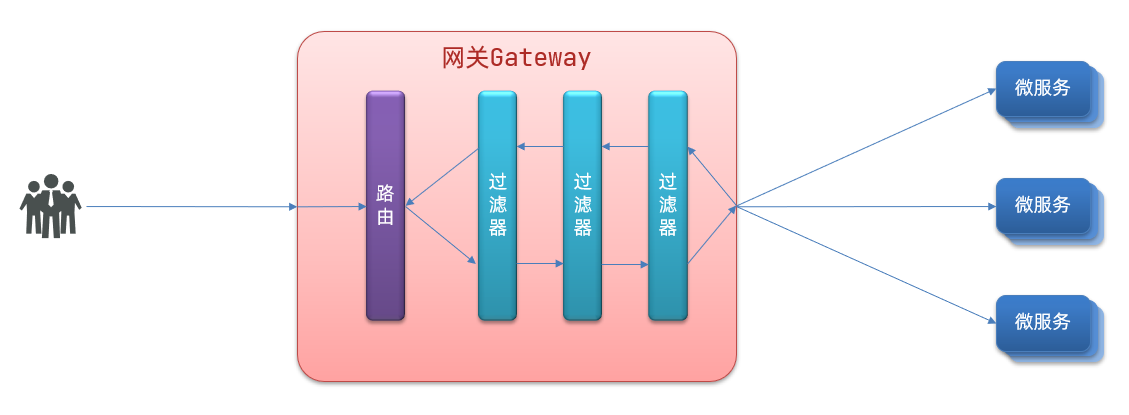

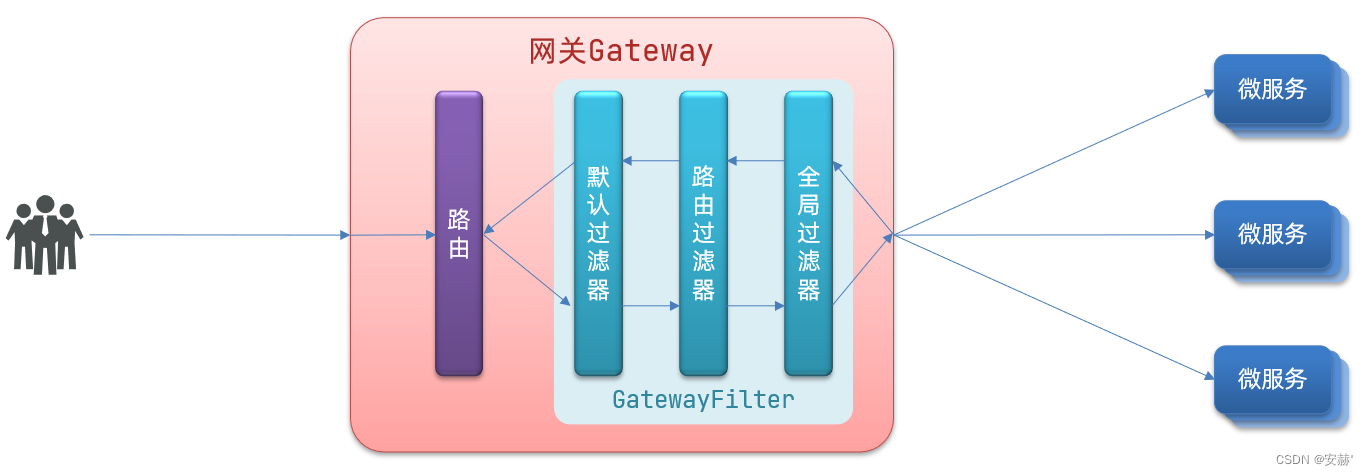

8.4.过滤器工厂

GatewayFilter是网关中提供的一种过滤器,可以对进入网关的请求和微服务返回的响应做处理:

8.4.1.路由过滤器的种类

8.4.2.请求头过滤器

下面我们以AddRequestHeader 为例来讲解。

需求:给所有进入userservice的请求添加一个请求头:Truth=itcast is freaking awesome!

只需要修改gateway服务的application.yml文件,添加路由过滤即可:

1 | spring: |

8.4.3.默认过滤器

如果要对所有的路由都生效,则可以将过滤器工厂写到default下。格式如下:

1 | spring: |

8.4.4.总结

过滤器的作用是什么?

① 对路由的请求或响应做加工处理,比如添加请求头

② 配置在路由下的过滤器只对当前路由的请求生效

defaultFilters的作用是什么?

① 对所有路由都生效的过滤器

8.5.全局过滤器

上一节学习的过滤器,网关提供了31种,但每一种过滤器的作用都是固定的。如果我们希望拦截请求,做自己的业务逻辑则没办法实现。

8.5.1.全局过滤器作用

全局过滤器的作用也是处理一切进入网关的请求和微服务响应,与GatewayFilter的作用一样。区别在于GatewayFilter通过配置定义,处理逻辑是固定的;而GlobalFilter的逻辑需要自己写代码实现。

定义方式是实现GlobalFilter接口。

1 | public interface GlobalFilter { |

在filter中编写自定义逻辑,可以实现下列功能:

登录状态判断

权限校验

请求限流等

8.5.2.自定义全局过滤器

需求:定义全局过滤器,拦截请求,判断请求的参数是否满足下面条件:

参数中是否有authorization,

authorization参数值是否为admin

如果同时满足则放行,否则拦截

实现:

在gateway中定义一个过滤器:

1 | package cn.itcast.gateway.filters; |

8.5.3.过滤器执行顺序

请求进入网关会碰到三类过滤器:当前路由的过滤器、DefaultFilter、GlobalFilter

请求路由后,会将当前路由过滤器和DefaultFilter、GlobalFilter,合并到一个过滤器链(集合)中,排序后依次执行每个过滤器:

排序的规则是什么呢?

每一个过滤器都必须指定一个int类型的order值,order值越小,优先级越高,执行顺序越靠前。

GlobalFilter通过实现Ordered接口,或者添加@Order注解来指定order值,由我们自己指定

路由过滤器和defaultFilter的order由Spring指定,默认是按照声明顺序从1递增。

当过滤器的order值一样时,会按照 defaultFilter > 路由过滤器 > GlobalFilter的顺序执行。

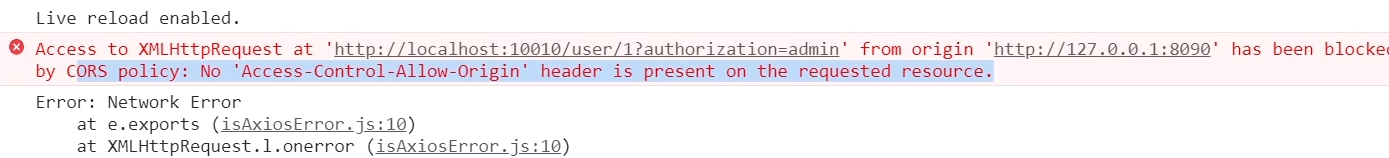

8.6.跨域问题

8.6.1.什么是跨域问题

跨域:域名不一致就是跨域,主要包括:

域名不同: www.taobao.com 和 www.taobao.org 和 www.jd.com 和 miaosha.jd.com

域名相同,端口不同:localhost:8080和localhost8081

跨域问题:浏览器禁止请求的发起者与服务端发生跨域ajax请求,请求被浏览器拦截的问题

解决方案:CORS,这个以前应该学习过,这里不再赘述了。放入tomcat或者nginx这样的web服务器中,启动并访问。

8.6.2.模拟跨域问题

可以在浏览器控制台看到下面的错误:

从localhost:8090访问localhost:10010,端口不同,显然是跨域的请求。

8.6.3.解决跨域问题

在gateway服务的application.yml文件中,添加下面的配置:

1 | spring: |

10、MQ(Message Queue)消息队列

10.1 概述

事件驱动架构的概念:

MQ是事件驱动架构的实现形式,MQ其实就是事件驱动架构的Broker。

异步应用场景:

如果是传统软件行业:虽然不需要太高并发,但是涉及到和其它系统做对接,我方系统处理速度(50ms)远快于对方系统处理速度(1-3s),为了兼顾用户的体验,加快单据处理速度,故引入MQ。

用户只用点击我方系统的按钮,我方按钮发送到MQ即可给用户返回处理成功信息。背后交由对方系统做处理即可。至于处理失败,补偿机制就不是用户体验要考虑的事情了,这样可以大大提升用户体验。

异步通讯优缺点:

优点:

耦合度低

吞吐量提升

故障隔离

流量削峰

缺点:

- 依赖于MQ的可靠性,安全性,吞吐能力(因为加了一层MQ,当然高度依赖它)

- 业务复杂了,业务没有明显的流程线,不好追踪管理

MQ常见技术介绍:

10.3 常见消息模型

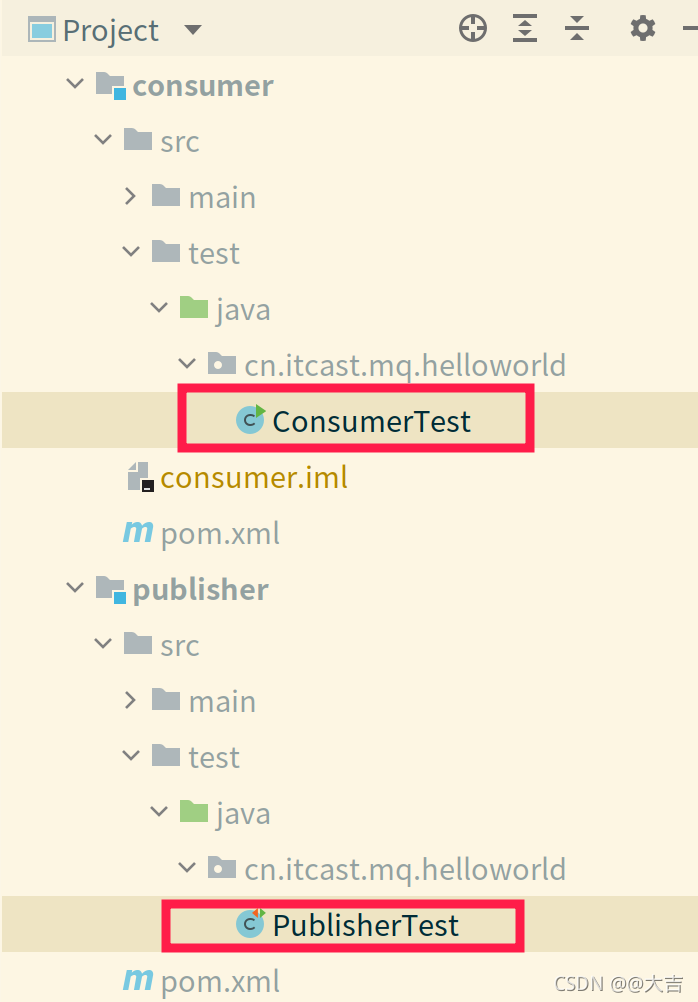

10.3.1 简单队列模型

核心代码位置:下图所示

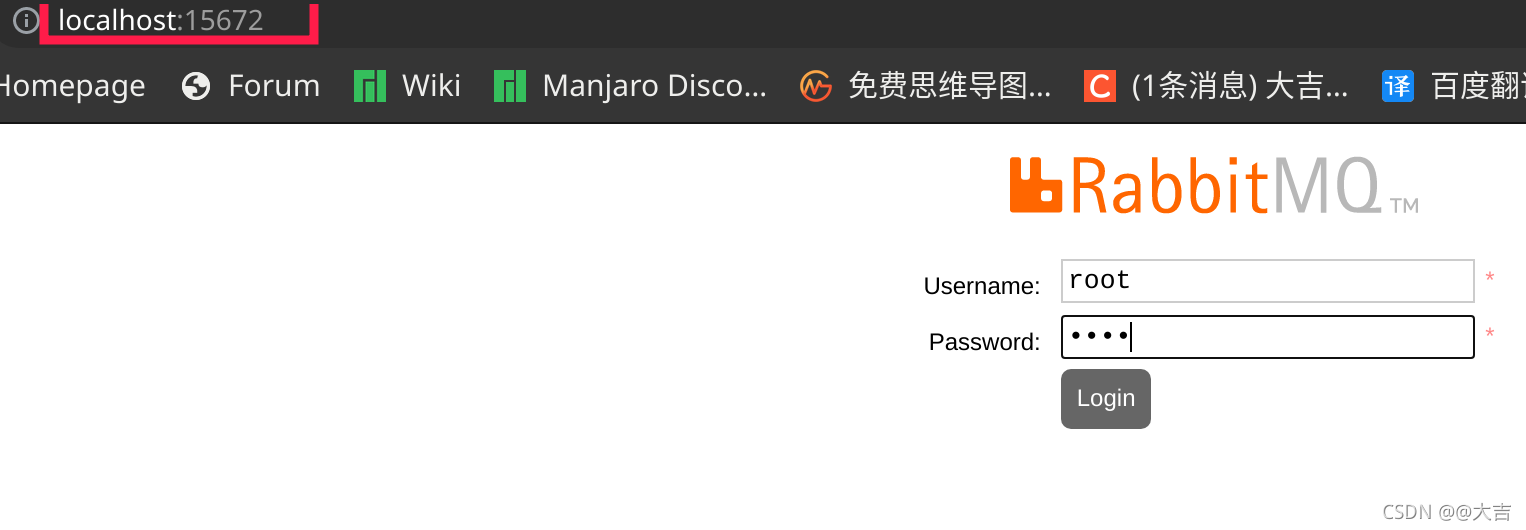

执行MQ容器的命令和简单说明:

1 | docker run \ |

最后在浏览器地址栏输入:你的端口号:15672

10.4 Spring AMQP

概述

AMQP(Advanced Message Queuing Protocol),是用于在应用程序之间传递业务信息的开放标准,该协议与语言和平台无关,更符合微服务中独立性的要求

SpringAMQP就是Spring基于AMQP定义的一套API规范。

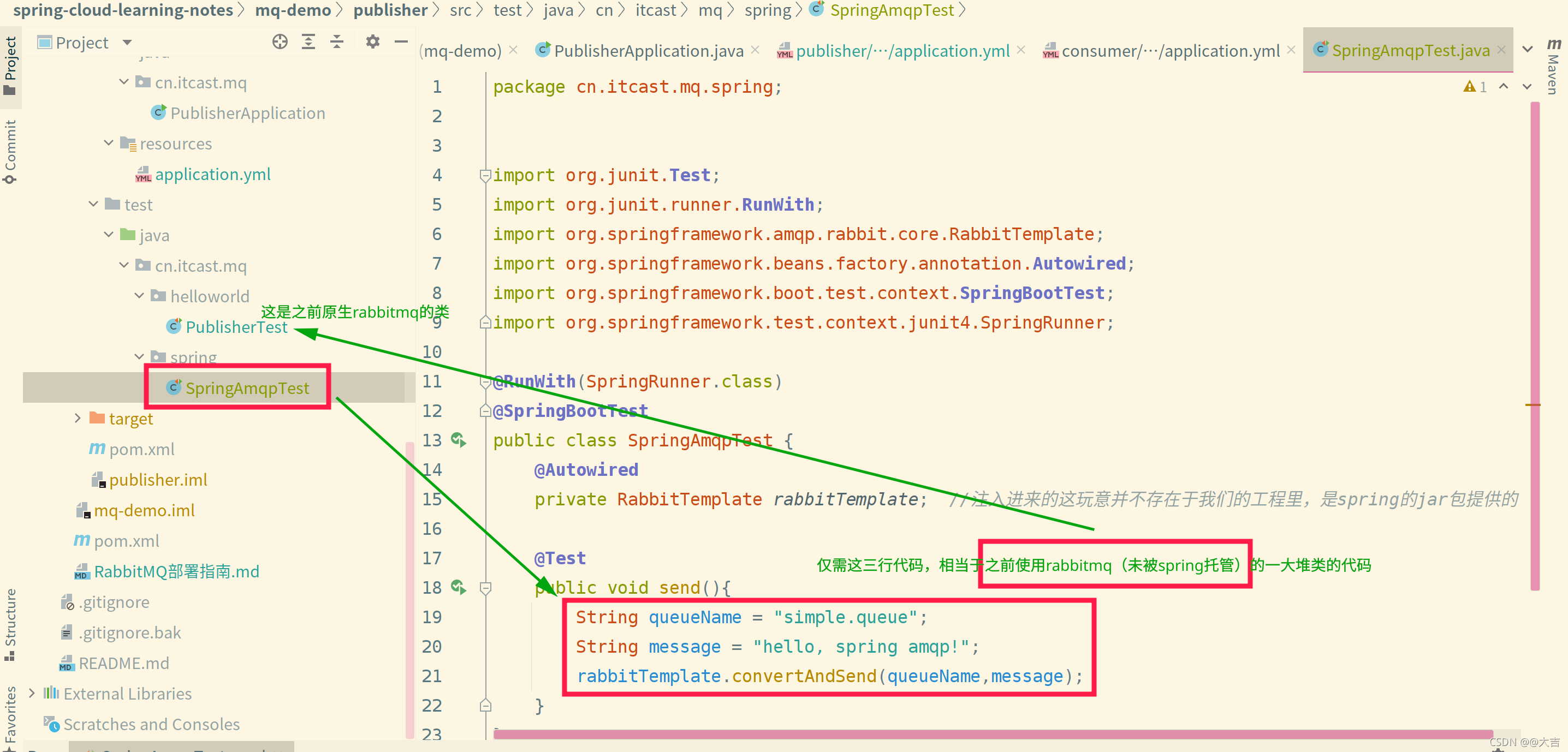

使用Spring AMQP实现简单队列模型步骤:

以生产者为例:

由于这玩意已被spring托管了,所以对比之前rabbitmq demo的方式,不需要在代码里写配置了,直接在spring的application.yml里写配置文件即可.

配置如下:

1 | 1.1.设置连接参数,分别是:主机名、端口号、用户名、密码、vhost |

然后编写测试类,以及测试代码,位置如下图所示:

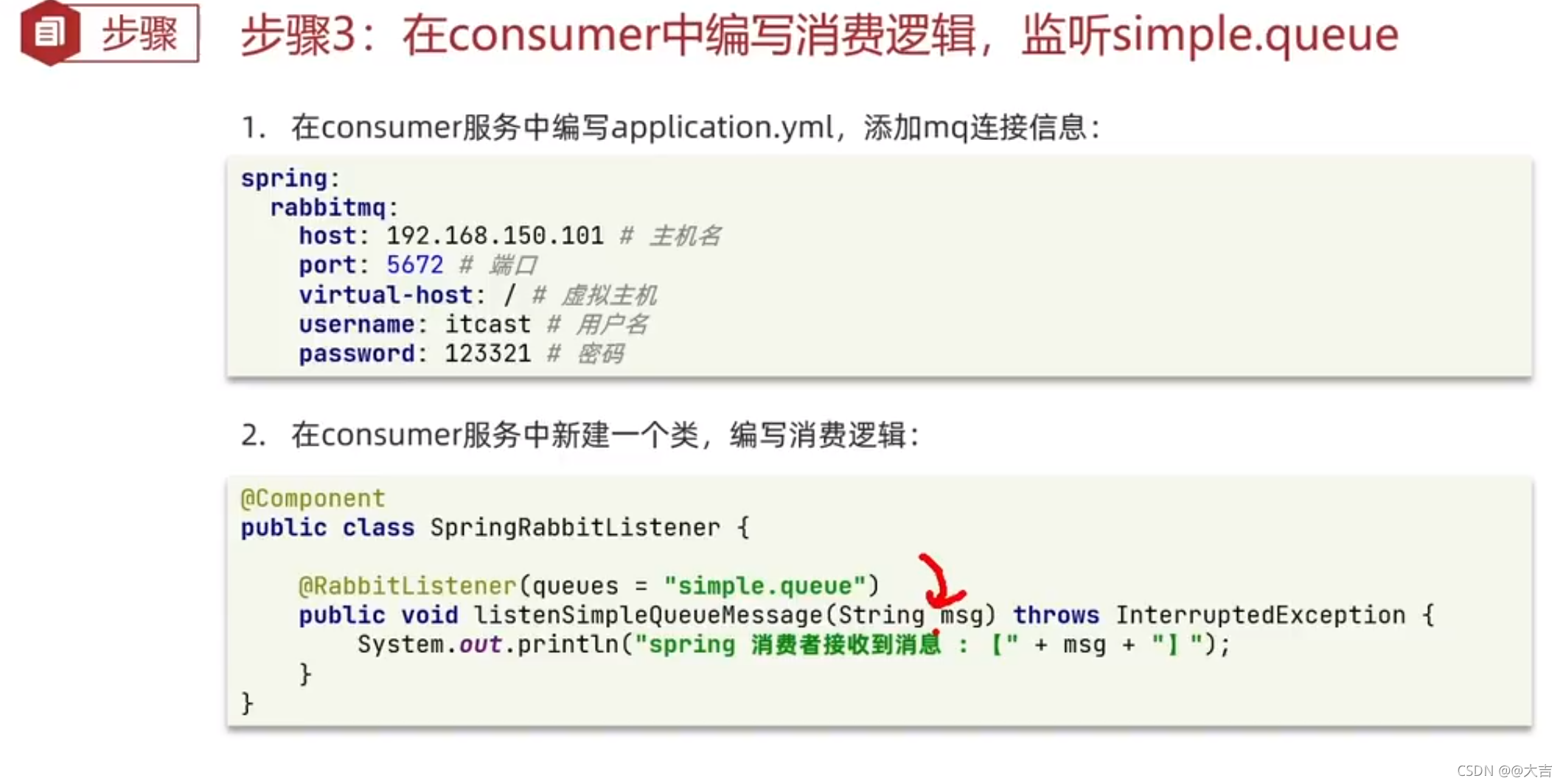

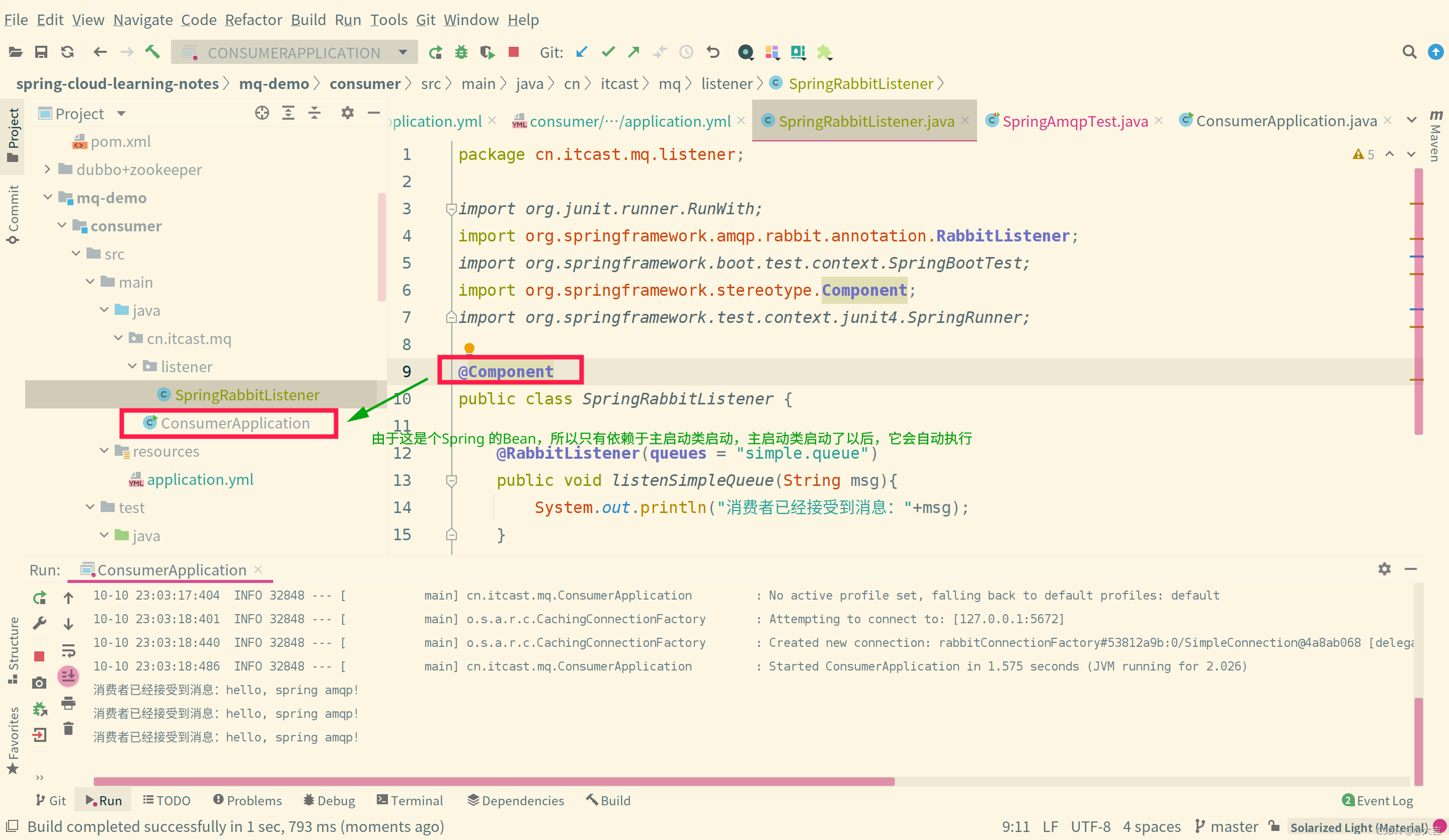

消费者一侧,和生产者类似。不再赘述,如下图进行配置即可:

至于如何启动消费者 一侧?如下图所示:

10.3.2 WorkQueue模型

之所以 10.3.2 放在 10.4章,因为demo模型的演示,今后就是以 Spring AMQP为例了

概述

其实就是一个队列,绑定了多个消费者,一条消息只能由一个消费者进行消费,默认情况下,每个消费者是轮询消费的。区别于下文的发布-订阅模型(该模型允许将同一消息发给多消费者)

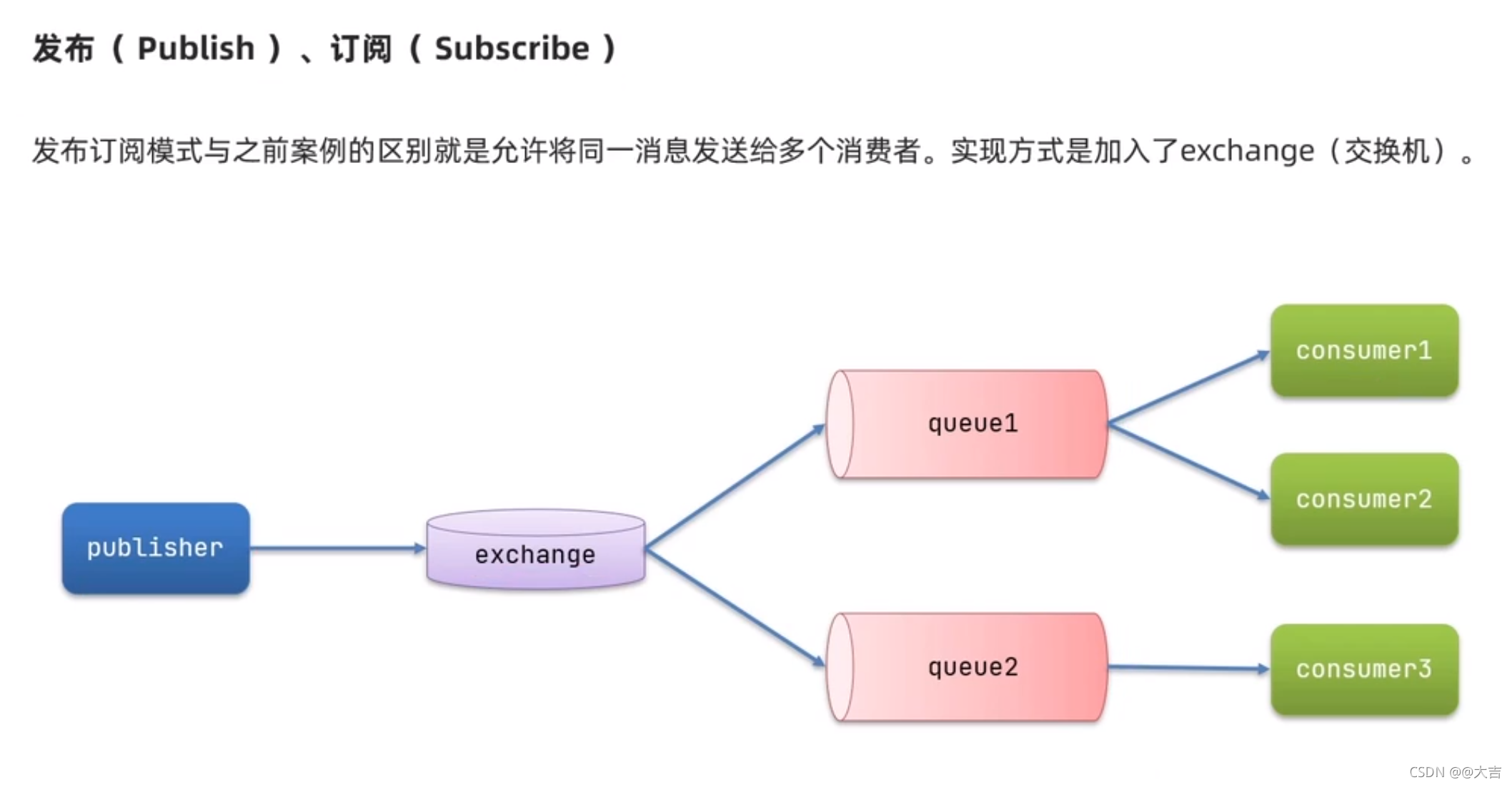

10.3.3 发布-订阅模型

概念

允许将同一个消息发给多个消费者。

其实就是加了一层交换机而已,如下图所示:许将同一消息发给多消费者)

最后,交换机只能做消息的转发而不是存储,如果将来路由(交换机和消息队列queue的连接称作路由)没有成功,消息会丢失

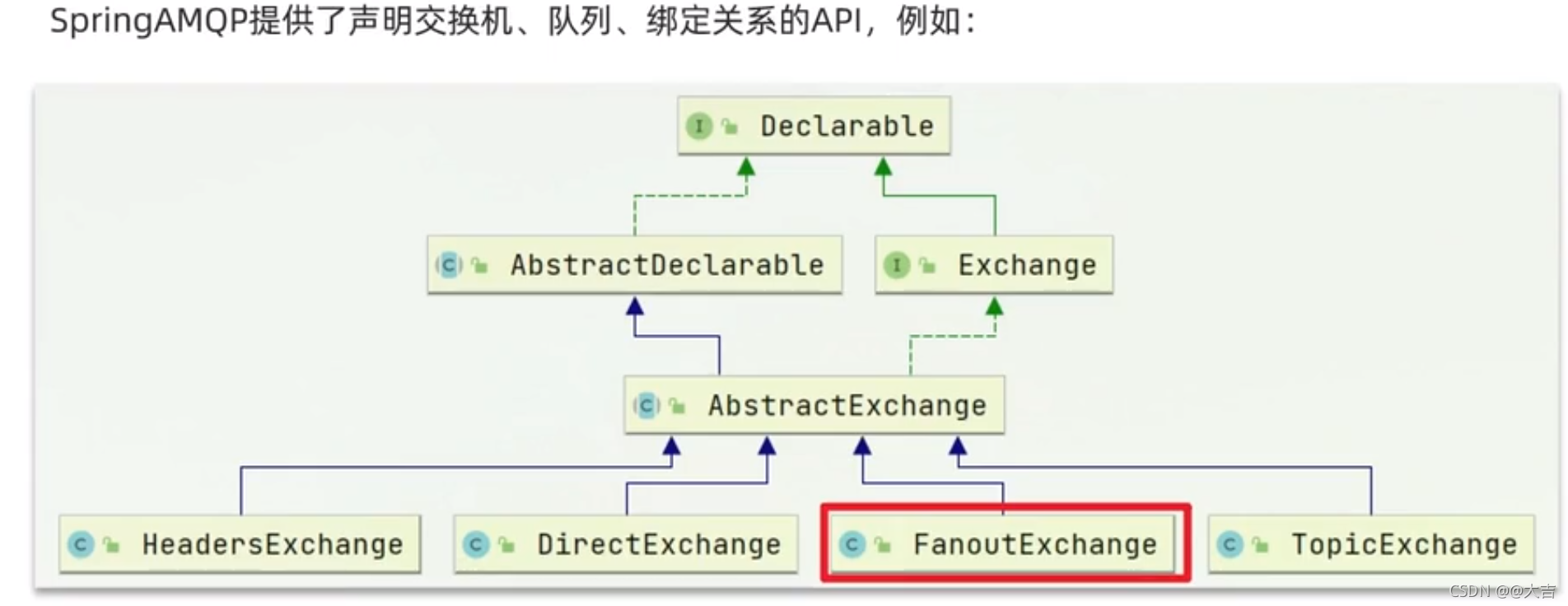

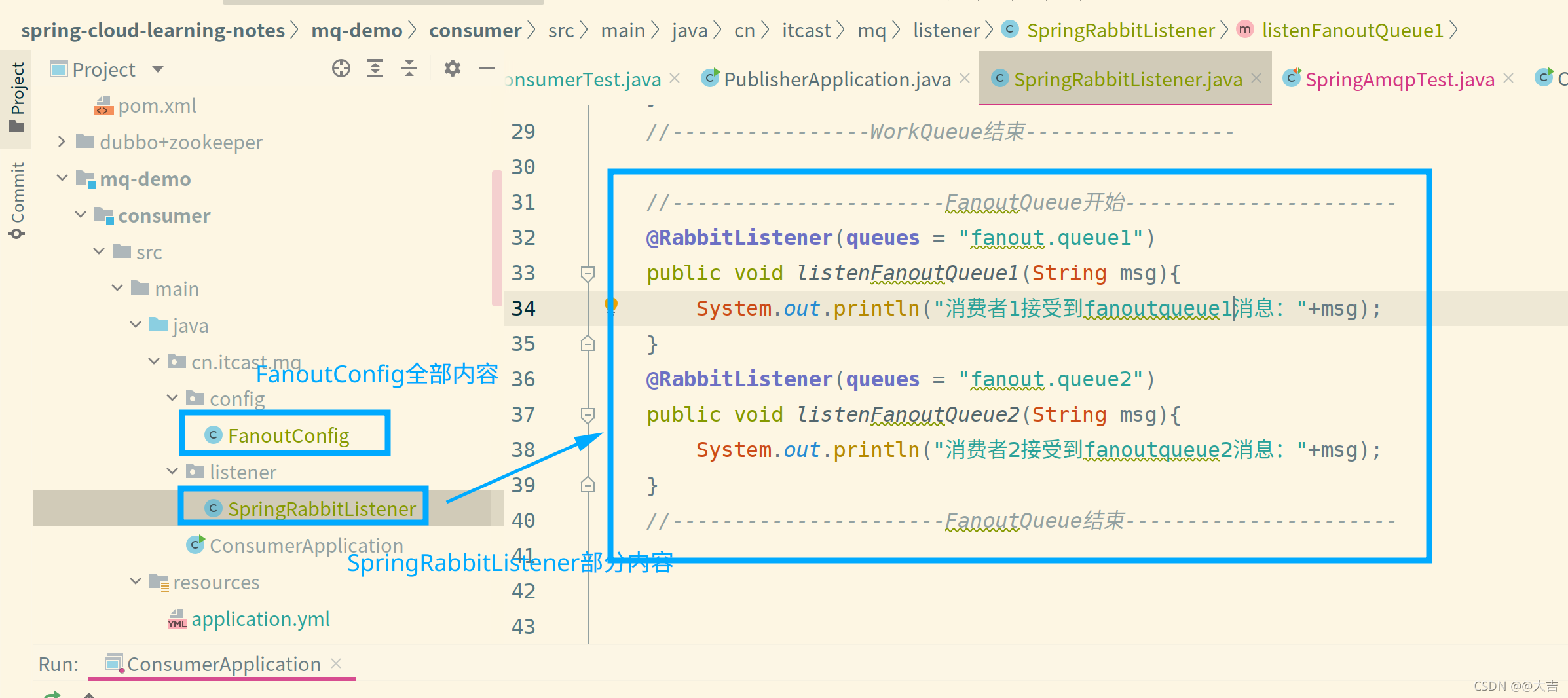

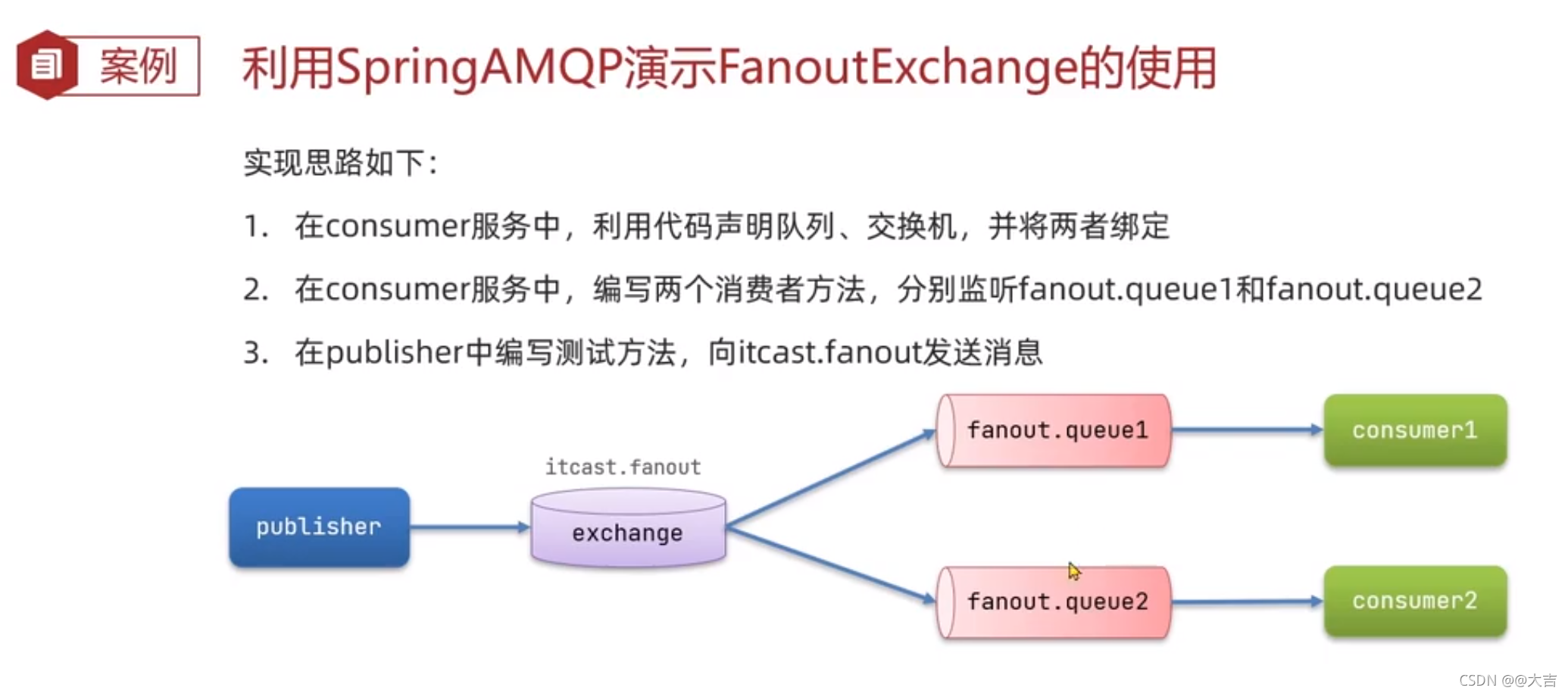

A. Fanout Exchange

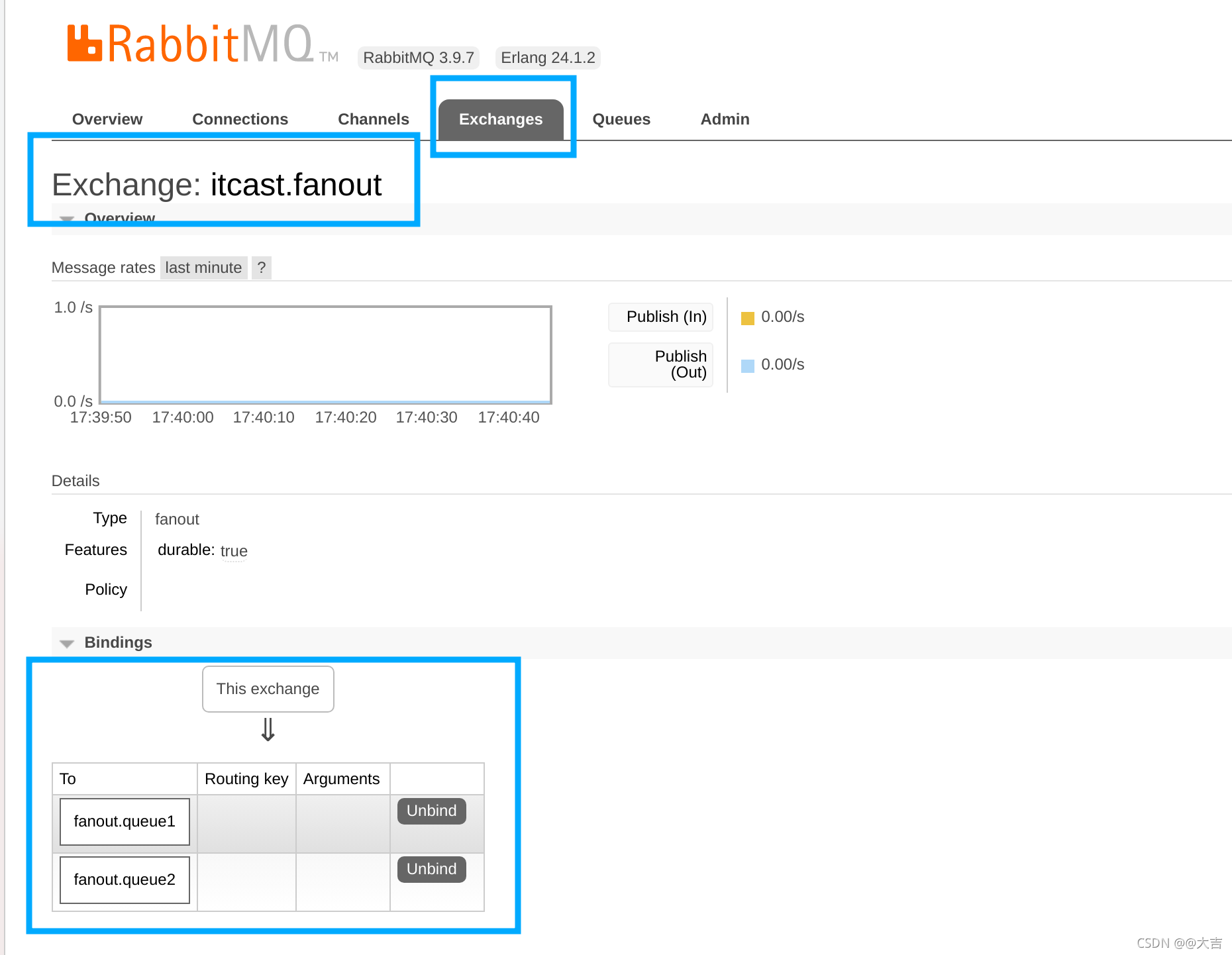

生产者添加代码位置如下图:

队列绑定成功后,打开mq可视化页面,会看到如下图所示:

概念:

这种模型中生产者发送的消息所有消费者都可以消费。

案例:

总结:workQueue模式和FanoutQueue模式区别:

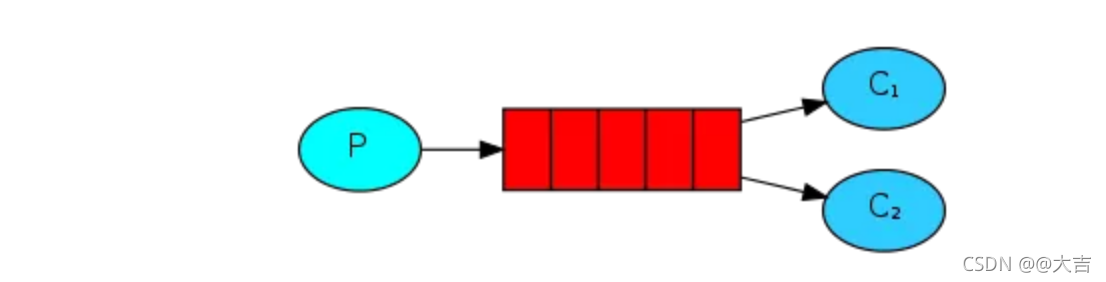

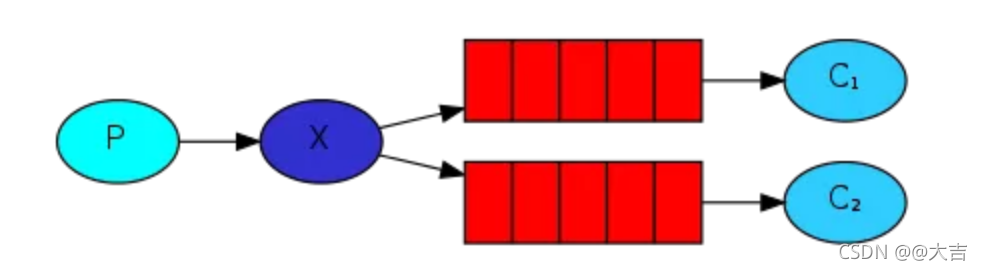

P代表生产者,C代表消费者 X代表交换机,红色部分代表消息队列

workQueue:

FanoutQUeue:

可以发现,FanoutQueue增加了一层交换机,可以多个队列对应多个消费者。而且比起WorkQueue,FanoutQueue生产者是先发送到交换机; 而WorkQueue是直接发送到队列

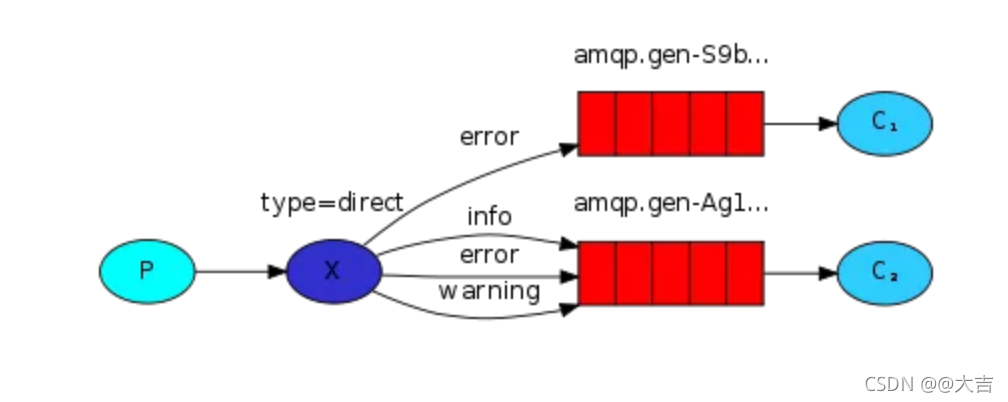

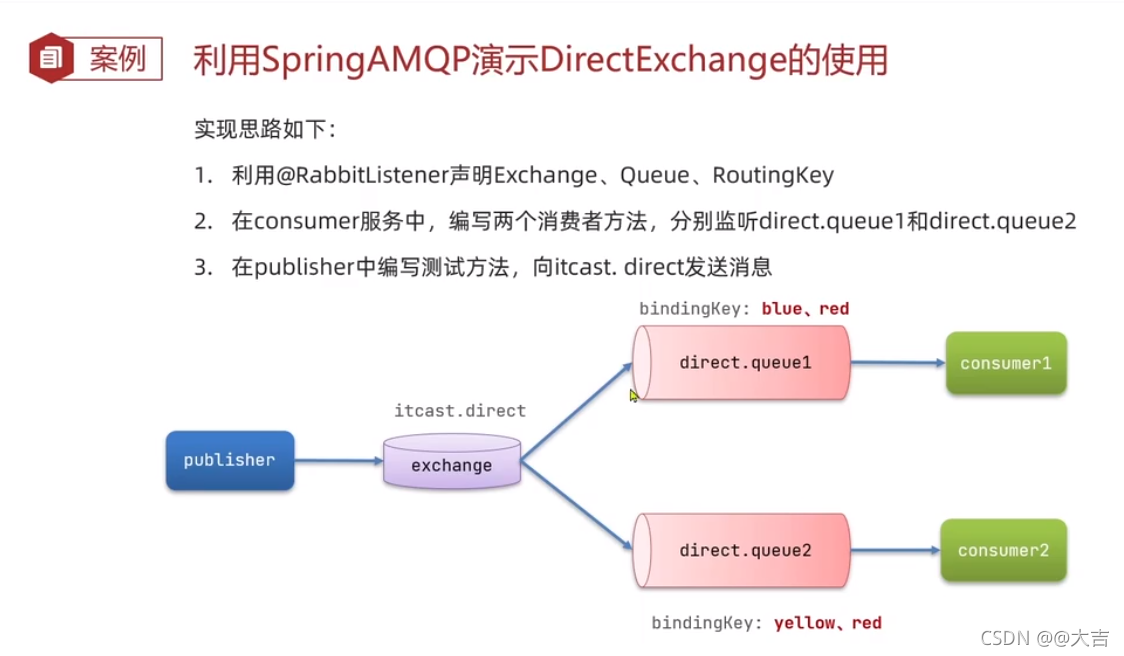

B. Direct Exchange

概念:DirectExchange 会将接收到的消息根据规则路由到指定的queue,因此称为路由模式,如下图所示:

P代表生产者,C代表消费者 X代表交换机,红色部分代表消息队列

每一个queue都会与Exchange设置一个BindingKey

将来发布者发布消息时,会指定消息的RoutingKey

Exchange将消息路由到BingingKey与RoutingKey一致的队列

实际应用时,可以绑定多个key。

如果所有queue和所有Exchange绑定了一样的key,那生产者所有符合key的消息消费者都会消费。如果这样做,那DirectExchange就相当于FanoutExchange了(Direct可以模拟Fanout的全部功能)

案例如图:

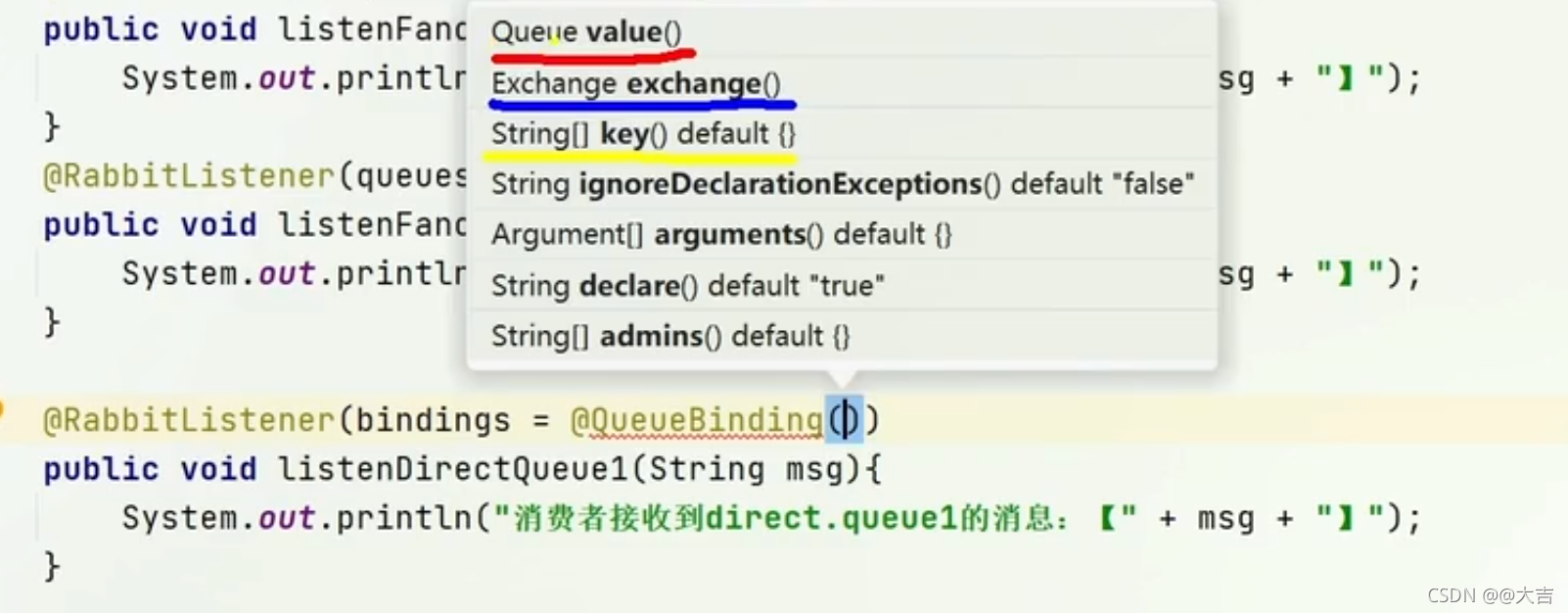

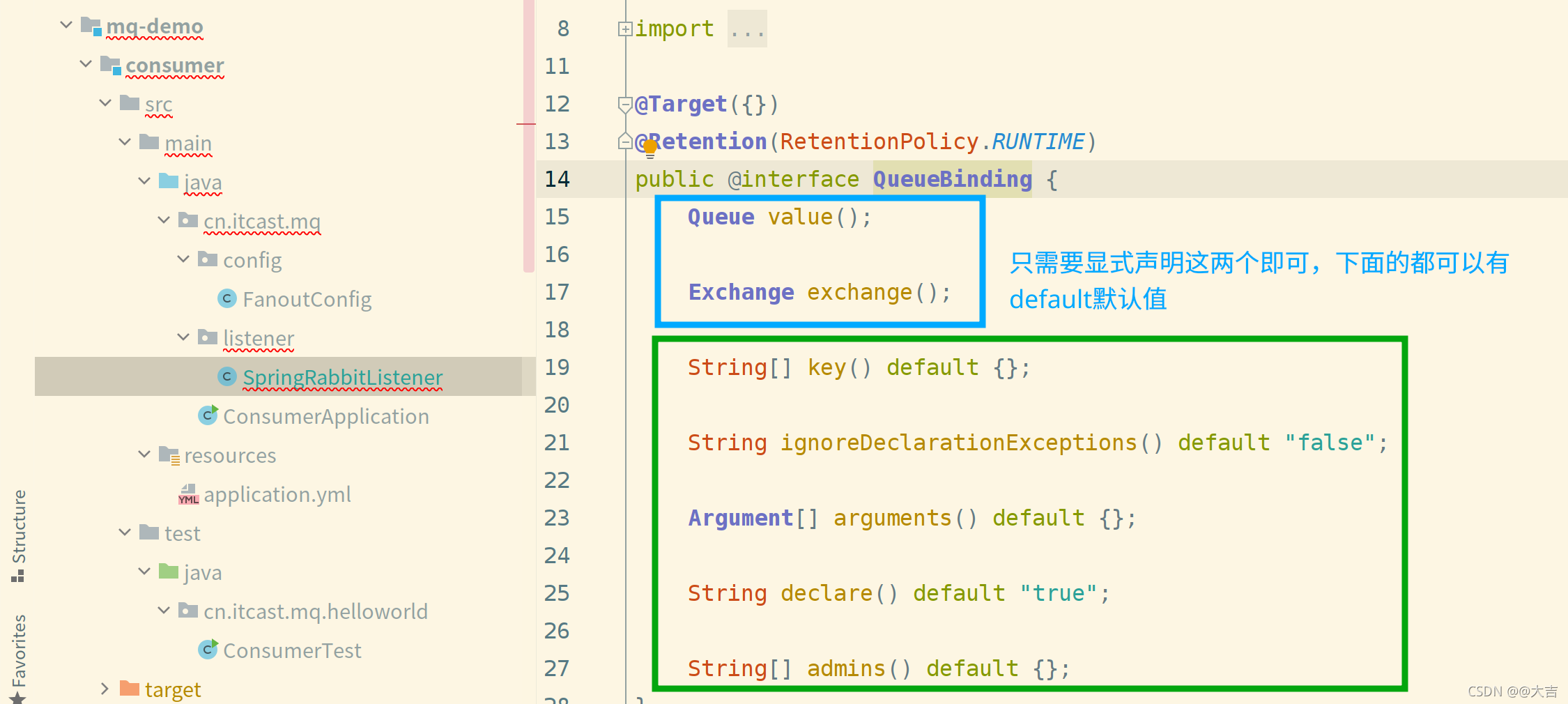

这次的案例,我们用注解的方式声明队列和绑定交换机,之前Fanout的Demo是手写了个配置类。 直接在监听队列里面声明如下图注解即可:

上图的@QueueBinding点进去:

上面的key是个数组,可以写多个key。

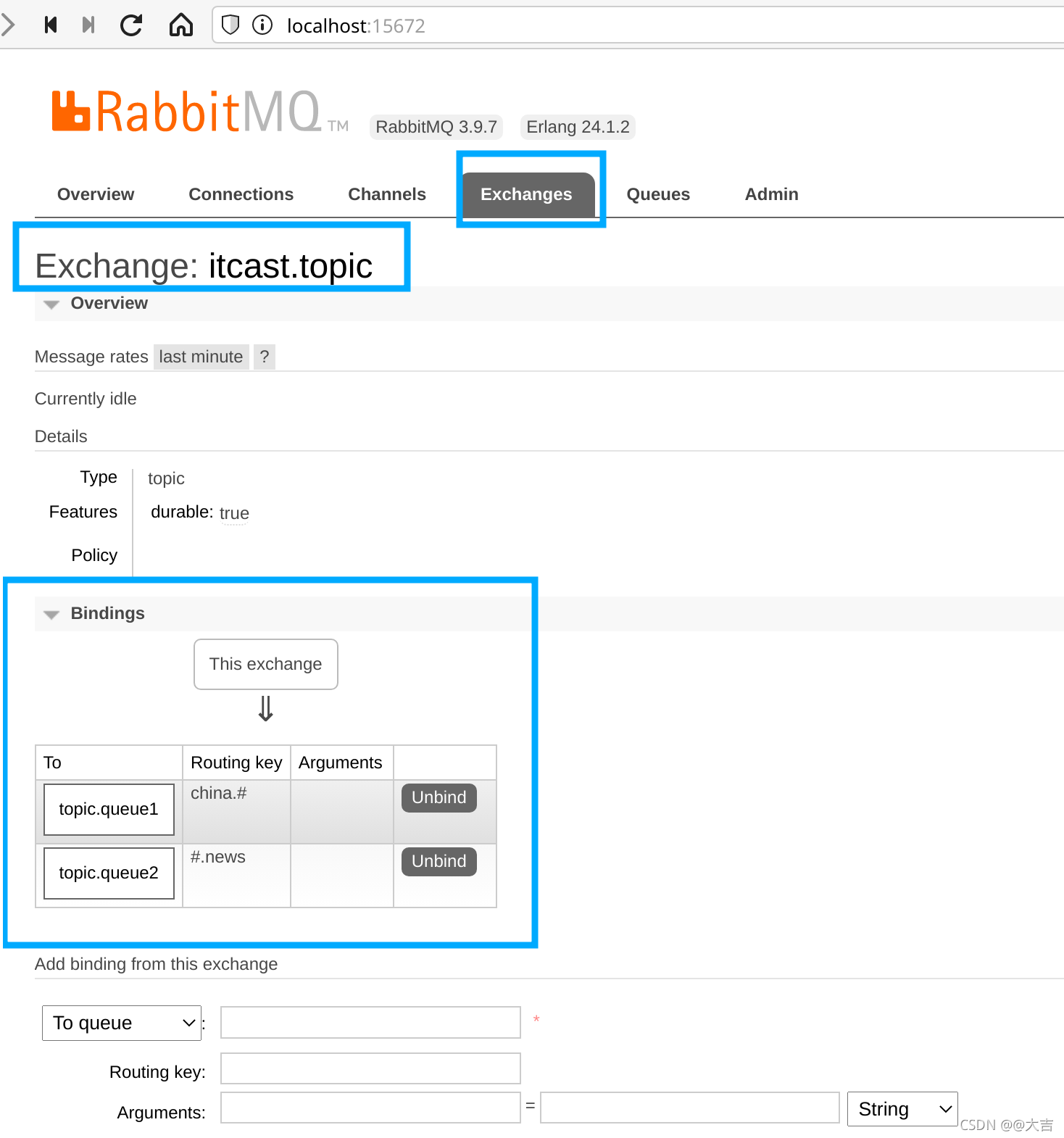

写完代码后启动消费者的SpiringBoot主启动类(报错信息不用管),然后进入rabbitMQ可视化控制台,出现下图则说明配置成功:

随后运行发送队列的Test代码,打开消费者的控制台,出现如下图输出,则说明案例测试通过:

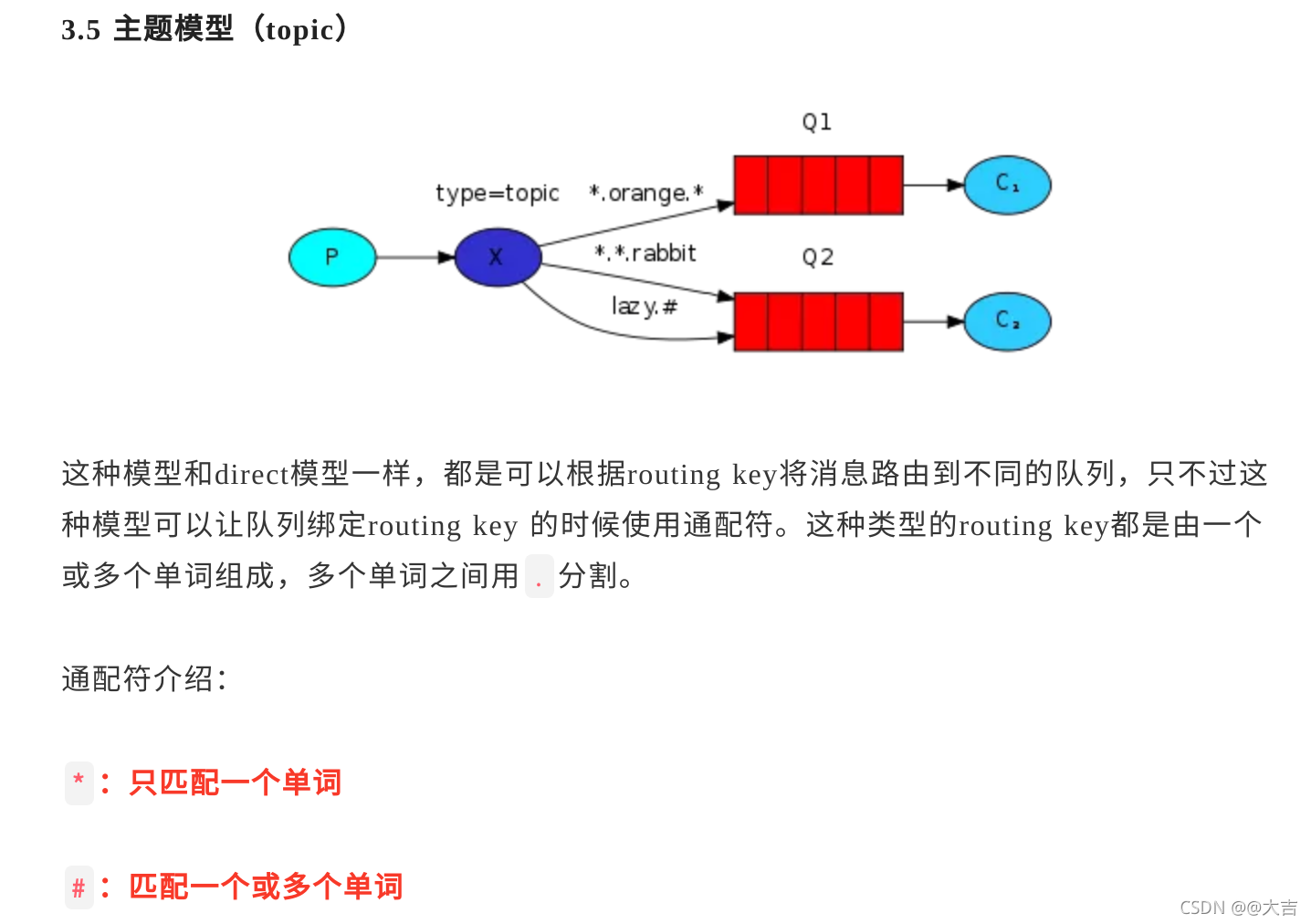

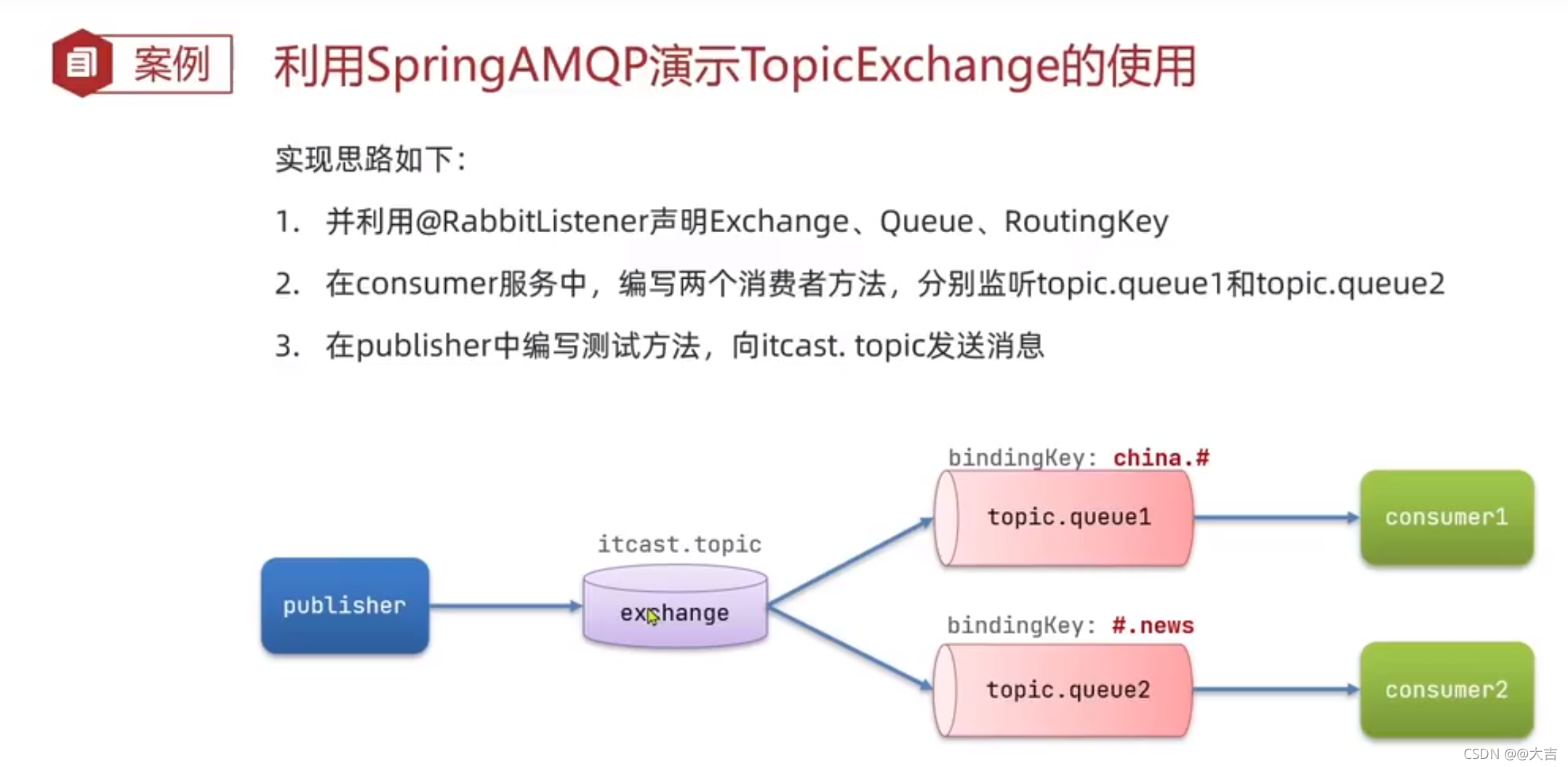

C. Topic Exchange

概念: 和上面的Direct Exchange及其相似:

(下图来源于Java旅途 ,作者大尧)

案例:

发送队列、消费者的添加代码位置和上面的DirectExchange位置一致,就在DirectExchange代码下面。

写完代码后启动消费者的SpiringBoot主启动类(报错信息不用管),然后进入rabbitMQ可视化控制台,出现下图则说明配置成功:

10.3.4 消息转换器

引入:

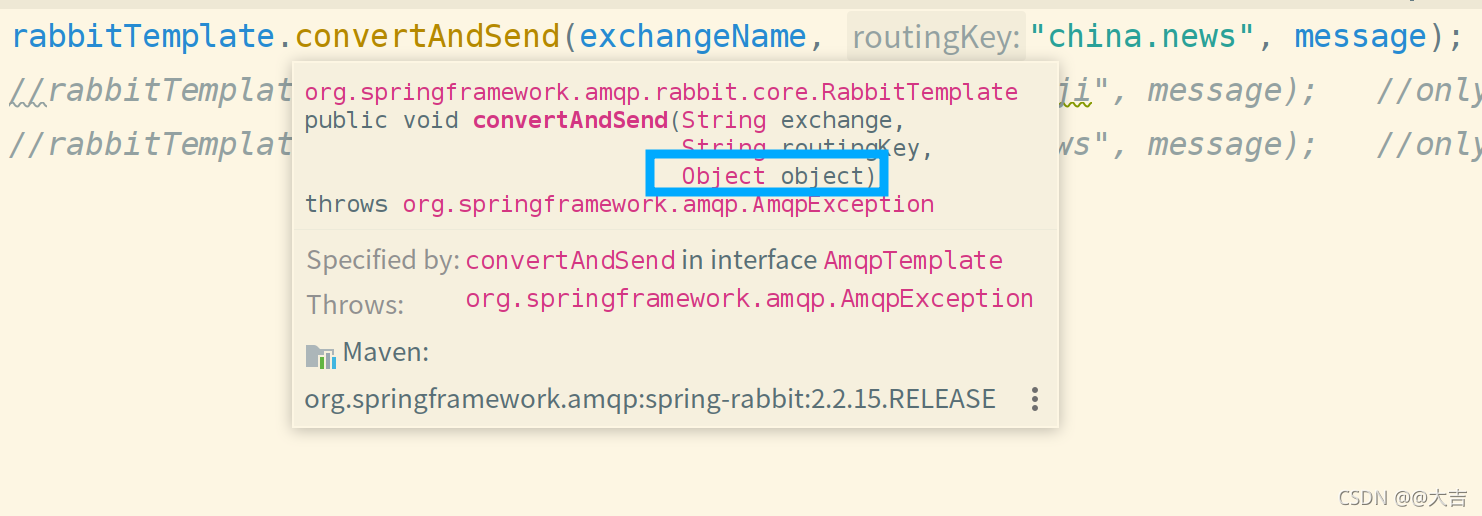

在之前的案例中,我们发送到队列的都是String类型,但是实际上,我们可以往消息队列中扔进去任何类型。我们看下图,convertAndSend这个方法,第三个参数也是Object。这说明可以发送任何类型给消息队列:

案例:

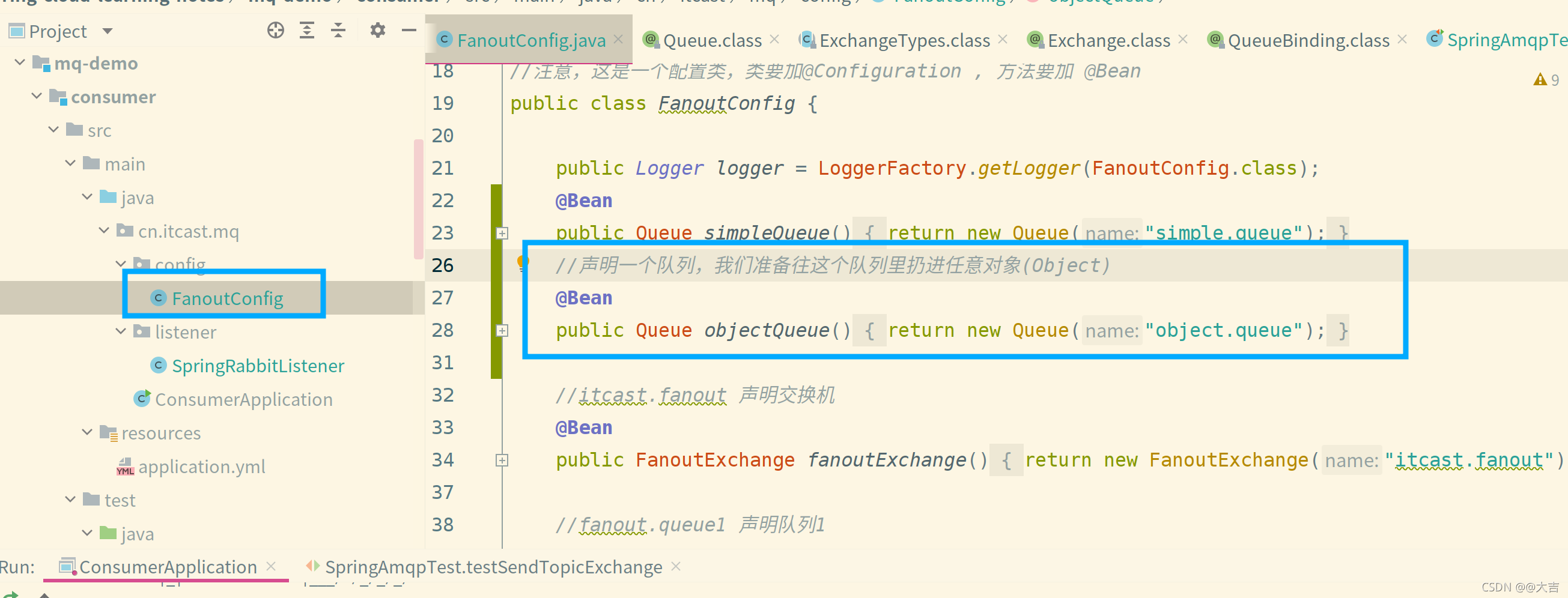

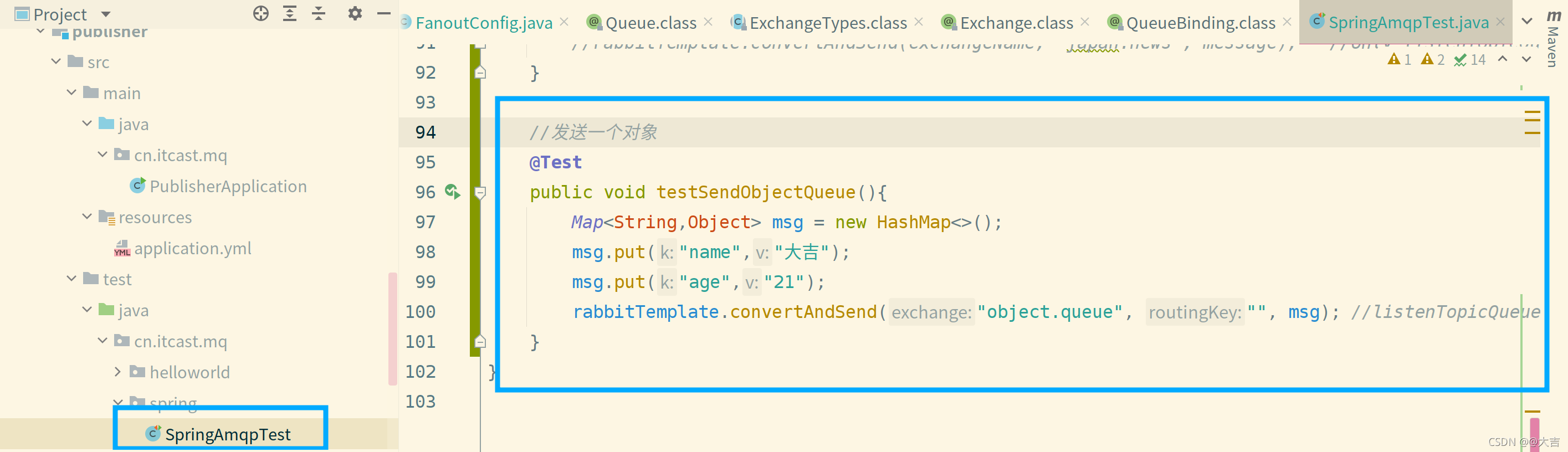

创建一个队列,向该队列扔一个任意对象(Object类型)

创建队列位置、发送队列的添加代码位置如下图

创建队列位置:

发送:

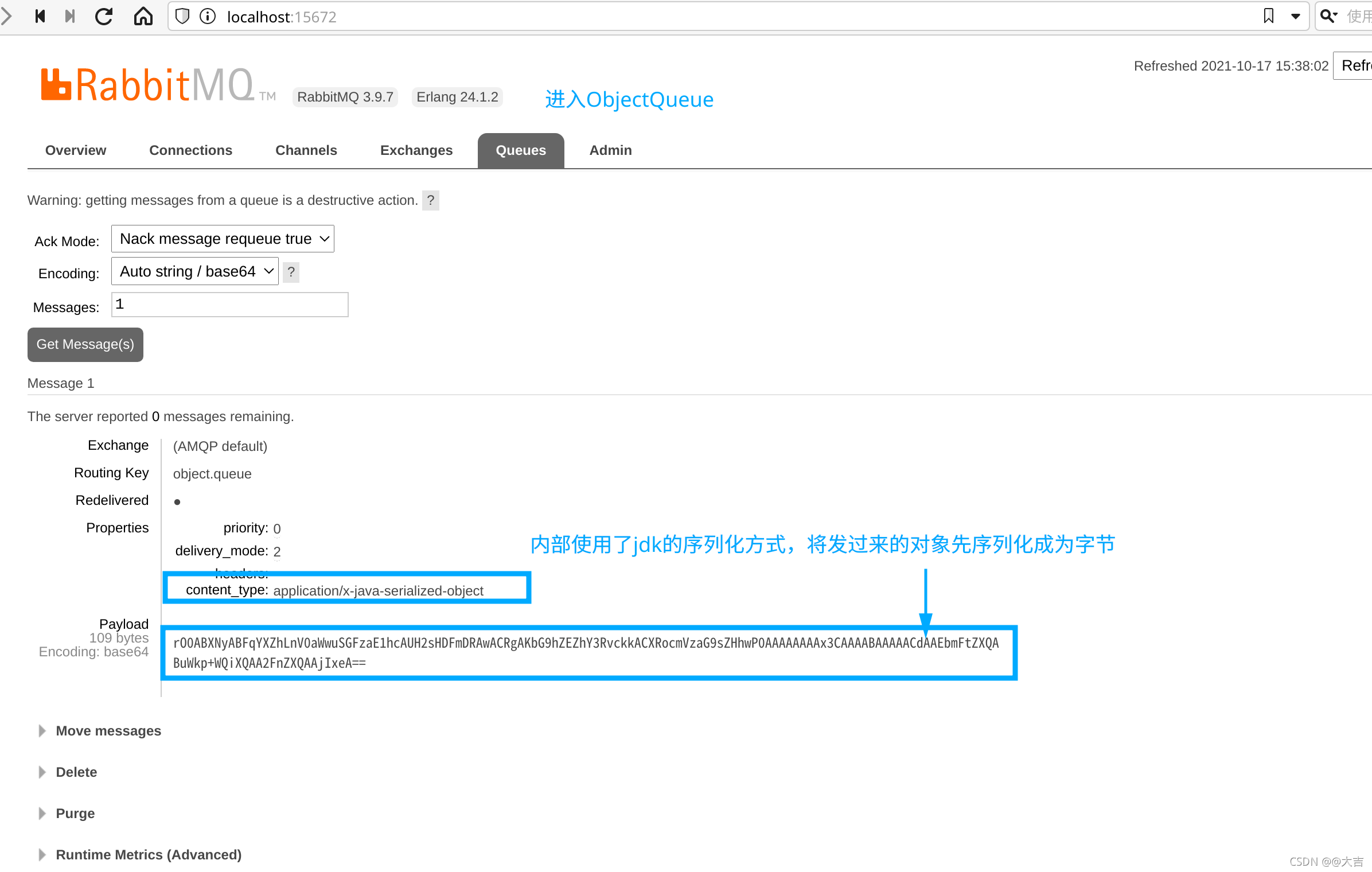

写完代码后启动发送的Test,去看RabbitMQ控制台,发现我们发过来的对象在内部被序列化(ObjectOutPutStream)了,如下图所示:

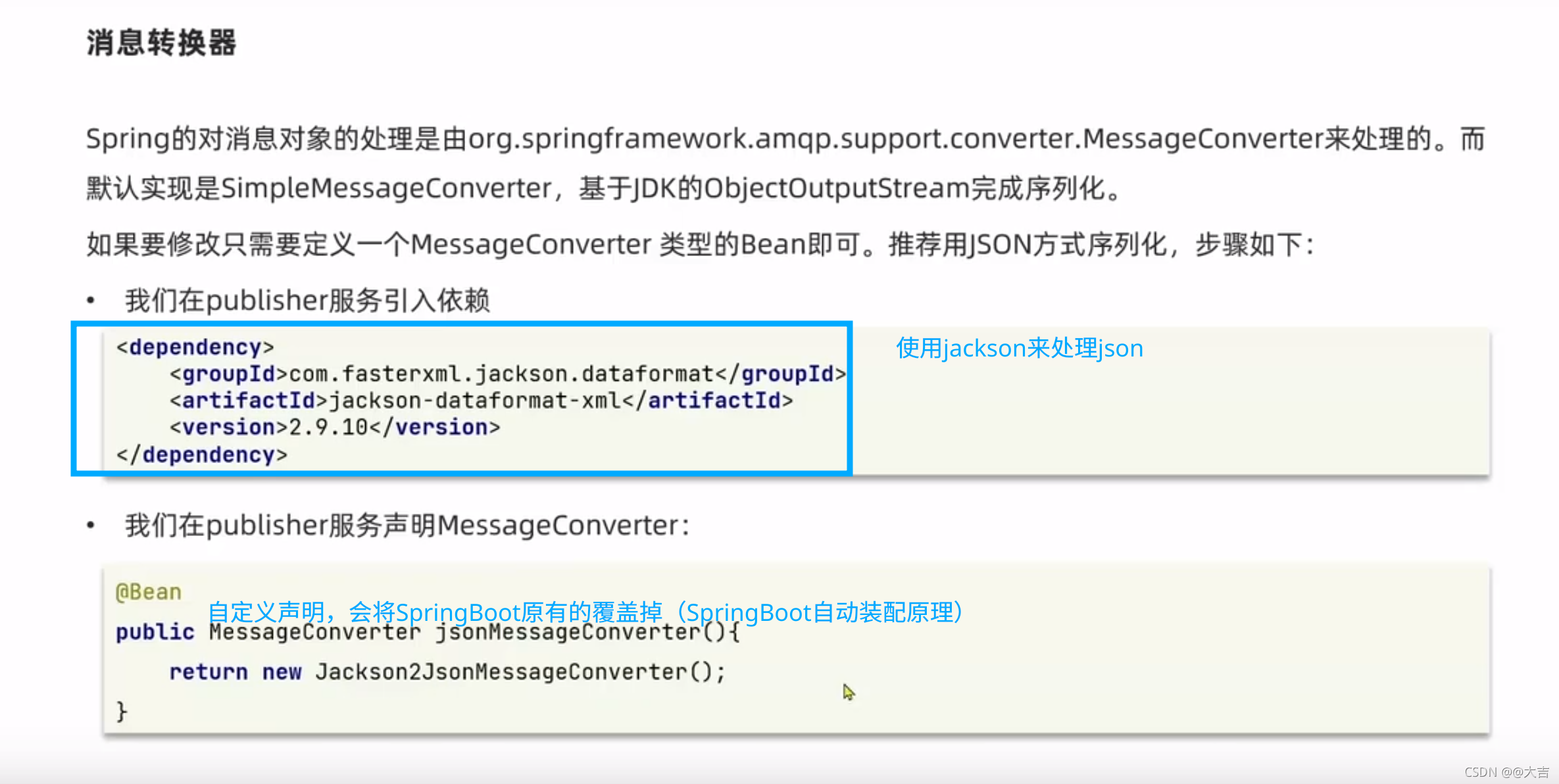

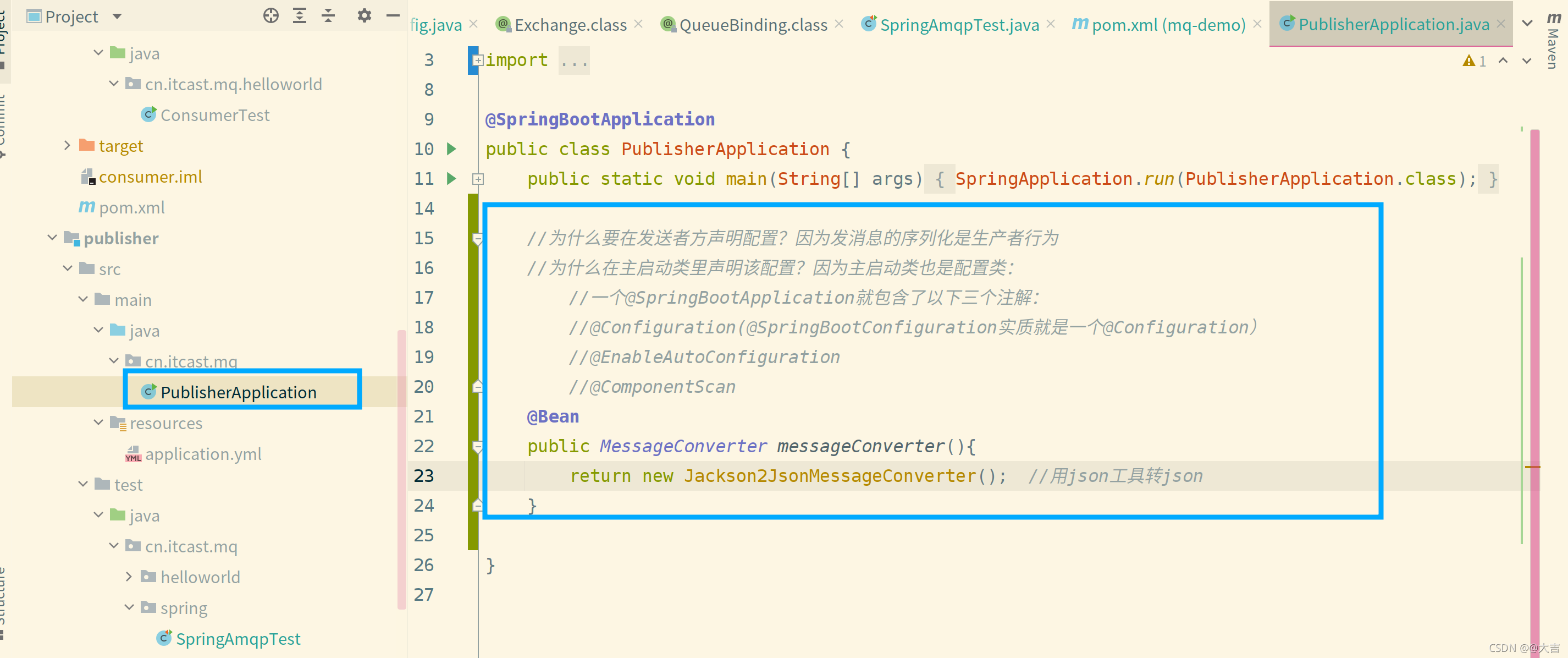

上面说的ObjectOutPutStream这个序列化方式,缺点很多(性能差、长度太长、安全性有问题)。我们可以在这里调优一下,推荐JSON的序列化方式。于是引出了这一节的正文:自定义消息转换器(覆盖了原有的Bean配置):

声明配置位置如下图

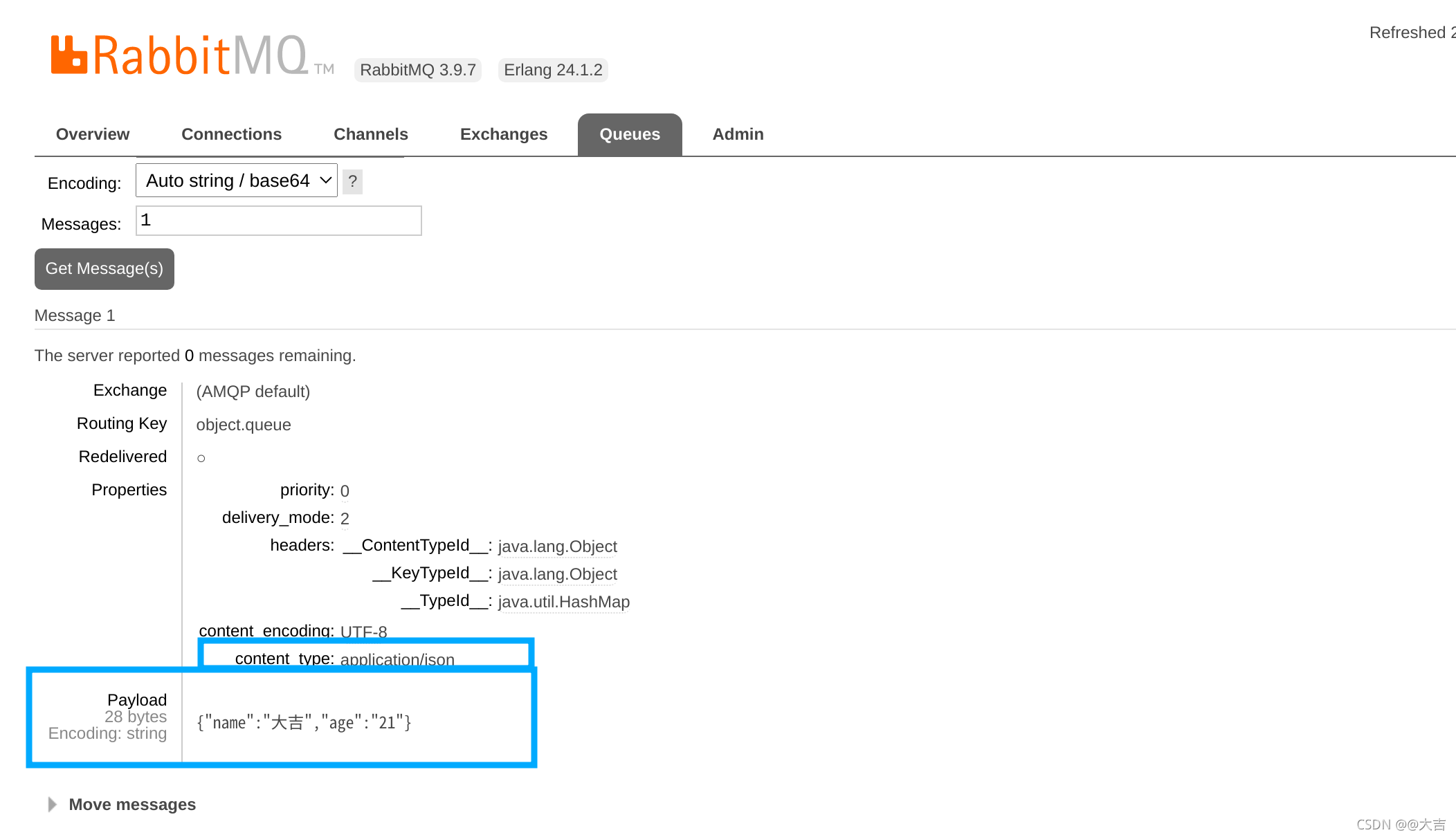

配置了消息转换器转换成json,然后重复之前的步骤,使用发送者发送一条消息到队列,发送完成后打开RabbitMQ控制台,出现如下图所示:

该对象被成功序列为json格式了!!!!!

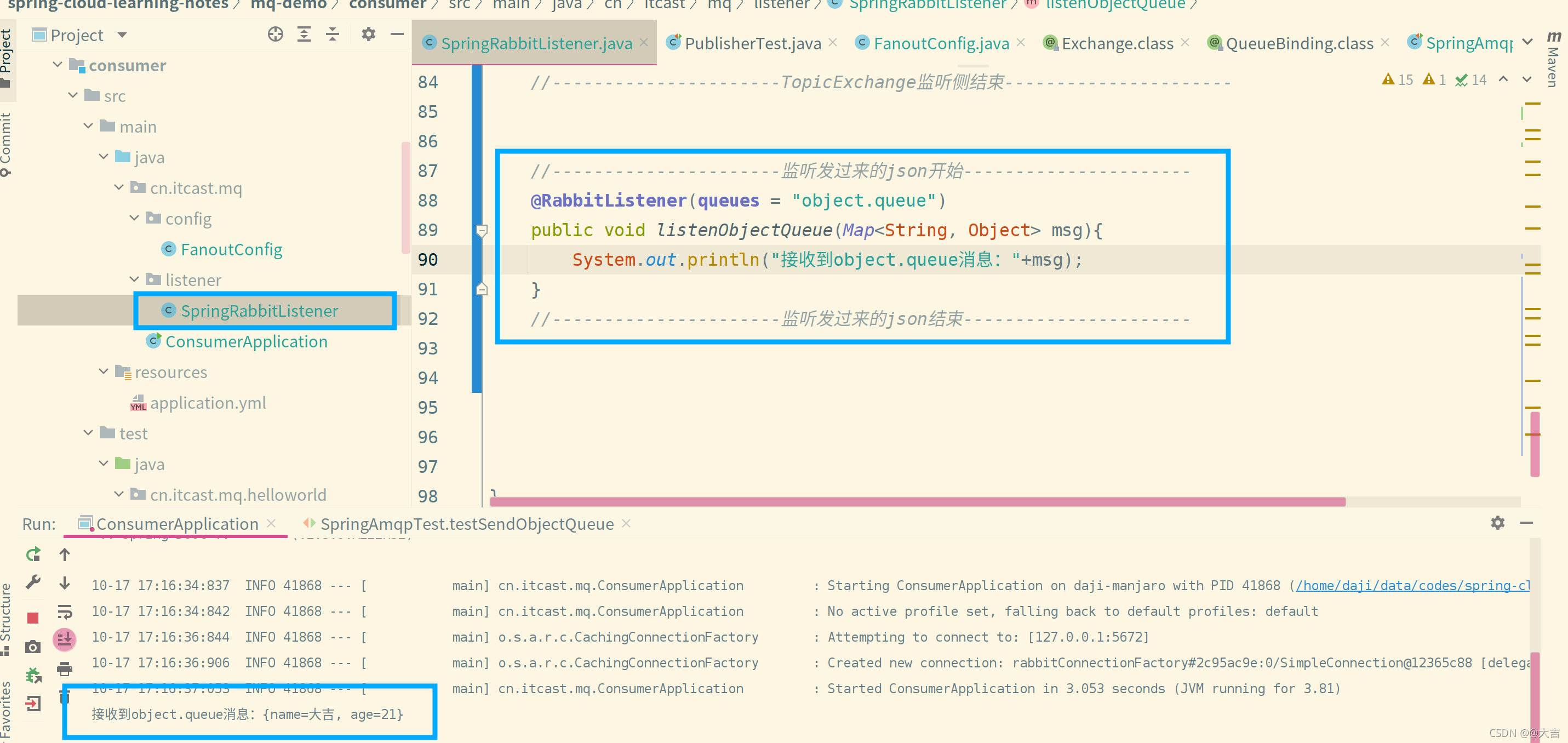

- 对刚才发送过来的json格式消息进行接收,需要修改消费者一侧的代码。并不复杂,如下图所示:

消费者配置、监听消息位置如下2图:

总结:

- 消息序列化和反序列化使用MessageConverter实现

- SpringAMQP的消息序列化默认底层是使用JDK的序列化

- 我们可以手动配置成其它的序列化方式(覆盖MessageConverter配置Bean),推荐json

- 发送方和接收方必须使用相同的MessageConverter

11、分布式搜索引擎01

– elasticsearch基础

1.1.了解ES

1.1.1.elasticsearch的作用

elasticsearch是一款非常强大的开源搜索引擎,具备非常多强大功能,可以帮助我们从海量数据中快速找到需要的内容

1.1.2.ELK技术栈

elasticsearch结合kibana、Logstash、Beats,也就是elastic stack(ELK)。被广泛应用在日志数据分析、实时监控等领域:

\讲义\assets\image-20210720194008781.png)

而elasticsearch是elastic stack的核心,负责存储、搜索、分析数据。

\讲义\assets\image-20210720194230265.png)

1.1.3.elasticsearch和lucene

elasticsearch底层是基于lucene来实现的。

1.1.4.总结

什么是elasticsearch?

- 一个开源的分布式搜索引擎,可以用来实现搜索、日志统计、分析、系统监控等功能

什么是elastic stack(ELK)?

- 是以elasticsearch为核心的技术栈,包括beats、Logstash、kibana、elasticsearch

什么是Lucene?

- 是Apache的开源搜索引擎类库,提供了搜索引擎的核心API

1.2.倒排索引

倒排索引的概念是基于MySQL这样的正向索引而言的。

1.2.1.正向索引

那么什么是正向索引呢?例如给下表(tb_goods)中的id创建索引:

\讲义\assets\image-20210720195531539.png)

如果是根据id查询,那么直接走索引,查询速度非常快。

但如果是基于title做模糊查询,只能是逐行扫描数据,流程如下:

1)用户搜索数据,条件是title符合"%手机%"

2)逐行获取数据,比如id为1的数据

3)判断数据中的title是否符合用户搜索条件

4)如果符合则放入结果集,不符合则丢弃。回到步骤1

逐行扫描,也就是全表扫描,随着数据量增加,其查询效率也会越来越低。当数据量达到数百万时,就是一场灾难。

1.2.2.倒排索引

倒排索引中有两个非常重要的概念:

- 文档(

Document):用来搜索的数据,其中的每一条数据就是一个文档。例如一个网页、一个商品信息 - 词条(

Term):对文档数据或用户搜索数据,利用某种算法分词,得到的具备含义的词语就是词条。例如:我是中国人,就可以分为:我、是、中国人、中国、国人这样的几个词条

创建倒排索引是对正向索引的一种特殊处理,流程如下:

- 将每一个文档的数据利用算法分词,得到一个个词条

- 创建表,每行数据包括词条、词条所在文档id、位置等信息

- 因为词条唯一性,可以给词条创建索引,例如hash表结构索引

如图:

\讲义\assets\image-20210720200457207.png)

倒排索引的搜索流程如下(以搜索”华为手机”为例):

1)用户输入条件"华为手机"进行搜索。

2)对用户输入内容分词,得到词条:华为、手机。

3)拿着词条在倒排索引中查找,可以得到包含词条的文档id:1、2、3。

4)拿着文档id到正向索引中查找具体文档。

如图:

\讲义\assets\image-20210720201115192.png)

虽然要先查询倒排索引,再查询倒排索引,但是无论是词条、还是文档id都建立了索引,查询速度非常快!无需全表扫描。

1.2.3.正向和倒排

那么为什么一个叫做正向索引,一个叫做倒排索引呢?

正向索引是最传统的,根据id索引的方式。但根据词条查询时,必须先逐条获取每个文档,然后判断文档中是否包含所需要的词条,是根据文档找词条的过程。

而倒排索引则相反,是先找到用户要搜索的词条,根据词条得到保护词条的文档的id,然后根据id获取文档。是根据词条找文档的过程。

是不是恰好反过来了?

那么两者方式的优缺点是什么呢?

正向索引:

- 优点:

- 可以给多个字段创建索引

- 根据索引字段搜索、排序速度非常快

- 缺点:

- 根据非索引字段,或者索引字段中的部分词条查找时,只能全表扫描。

倒排索引:

- 优点:

- 根据词条搜索、模糊搜索时,速度非常快

- 缺点:

- 只能给词条创建索引,而不是字段

- 无法根据字段做排序

1.3.es的一些概念

elasticsearch中有很多独有的概念,与mysql中略有差别,但也有相似之处。

1.3.1.文档和字段

elasticsearch是面向文档(Document)存储的,可以是数据库中的一条商品数据,一个订单信息。文档数据会被序列化为json格式后存储在elasticsearch中:

\讲义\assets\image-20210720202707797.png)

而Json文档中往往包含很多的字段(Field),类似于数据库中的列。

1.3.2.索引和映射

索引(Index),就是相同类型的文档的集合。

例如:

- 所有用户文档,就可以组织在一起,称为用户的索引;

- 所有商品的文档,可以组织在一起,称为商品的索引;

- 所有订单的文档,可以组织在一起,称为订单的索引;

\讲义\assets\image-20210720203022172.png)

因此,我们可以把索引当做是数据库中的表。

数据库的表会有约束信息,用来定义表的结构、字段的名称、类型等信息。因此,索引库中就有映射(mapping),是索引中文档的字段约束信息,类似表的结构约束。

1.3.3.mysql与elasticsearch

我们统一的把mysql与elasticsearch的概念做一下对比:

| MySQL | Elasticsearch | 说明 |

|---|---|---|

| Table | Index | 索引(index),就是文档的集合,类似数据库的表(table) |

| Row | Document | 文档(Document),就是一条条的数据,类似数据库中的行(Row),文档都是JSON格式 |

| Column | Field | 字段(Field),就是JSON文档中的字段,类似数据库中的列(Column) |

| Schema | Mapping | Mapping(映射)是索引中文档的约束,例如字段类型约束。类似数据库的表结构(Schema) |

| SQL | DSL | DSL是elasticsearch提供的JSON风格的请求语句,用来操作elasticsearch,实现CRUD |

是不是说,我们学习了elasticsearch就不再需要mysql了呢?

并不是如此,两者各自有自己的擅长支出:

Mysql:擅长事务类型操作,可以确保数据的安全和一致性

Elasticsearch:擅长海量数据的搜索、分析、计算

因此在企业中,往往是两者结合使用:

- 对安全性要求较高的写操作,使用mysql实现

- 对查询性能要求较高的搜索需求,使用elasticsearch实现

- 两者再基于某种方式,实现数据的同步,保证一致性

\讲义\assets\image-20210720203534945.png)

1.4.总结

分词器的作用是什么?

- 创建倒排索引时对文档分词

- 用户搜索时,对输入的内容分词

IK分词器有几种模式?

- ik_smart:智能切分,粗粒度

- ik_max_word:最细切分,细粒度

IK分词器如何拓展词条?如何停用词条?

- 利用config目录的IkAnalyzer.cfg.xml文件添加拓展词典和停用词典

- 在词典中添加拓展词条或者停用词条

2.索引库操作

索引库就类似数据库表,mapping映射就类似表的结构。

我们要向es中存储数据,必须先创建“库”和“表”。

2.1.mapping映射属性

mapping是对索引库中文档的约束,常见的mapping属性包括:

- type:字段数据类型,常见的简单类型有:

- 字符串:text(可分词的文本)、keyword(精确值,例如:品牌、国家、ip地址)

- 数值:long、integer、short、byte、double、float、

- 布尔:boolean

- 日期:date

- 对象:object

- index:是否创建索引,默认为true

- analyzer:使用哪种分词器

- properties:该字段的子字段

例如下面的json文档:

1 | { |

对应的每个字段映射(mapping):

- age:类型为 integer;参与搜索,因此需要index为true;无需分词器

- weight:类型为float;参与搜索,因此需要index为true;无需分词器

- isMarried:类型为boolean;参与搜索,因此需要index为true;无需分词器

- info:类型为字符串,需要分词,因此是text;参与搜索,因此需要index为true;分词器可以用ik_smart

- email:类型为字符串,但是不需要分词,因此是keyword;不参与搜索,因此需要index为false;无需分词器

- score:虽然是数组,但是我们只看元素的类型,类型为float;参与搜索,因此需要index为true;无需分词器

- name:类型为object,需要定义多个子属性

- name.firstName;类型为字符串,但是不需要分词,因此是keyword;参与搜索,因此需要index为true;无需分词器

- name.lastName;类型为字符串,但是不需要分词,因此是keyword;参与搜索,因此需要index为true;无需分词器

2.2.索引库的CRUD

这里我们统一使用Kibana编写DSL的方式来演示。

2.2.1.创建索引库和映射

基本语法:

- 请求方式:PUT

- 请求路径:/索引库名,可以自定义

- 请求参数:mapping映射

格式:

1 | PUT /索引库名称 |

示例:

1 | PUT /heima |

2.2.2.查询索引库

基本语法:

请求方式:GET

请求路径:/索引库名

请求参数:无

格式:

1 | GET /索引库名 |

示例:

\讲义\assets\image-20210720211019329.png)

2.2.3.修改索引库

倒排索引结构虽然不复杂,但是一旦数据结构改变(比如改变了分词器),就需要重新创建倒排索引,这简直是灾难。因此索引库一旦创建,无法修改mapping。

虽然无法修改mapping中已有的字段,但是却允许添加新的字段到mapping中,因为不会对倒排索引产生影响。

语法说明:

1 | PUT /索引库名/_mapping |

示例:

\讲义\assets\image-20210720212357390.png)

2.2.4.删除索引库

语法:

请求方式:DELETE

请求路径:/索引库名

请求参数:无

格式:

1 | DELETE /索引库名 |

在kibana中测试:

\讲义\assets\image-20210720212123420.png)

2.2.5.总结

索引库操作有哪些?

- 创建索引库:PUT /索引库名

- 查询索引库:GET /索引库名

- 删除索引库:DELETE /索引库名

- 添加字段:PUT /索引库名/_mapping

3.文档操作

3.1.新增文档

语法:

1 | POST /索引库名/_doc/文档id |

示例:

1 | POST /heima/_doc/1 |

响应:

\讲义\assets\image-20210720212933362.png)

3.2.查询文档

根据rest风格,新增是post,查询应该是get,不过查询一般都需要条件,这里我们把文档id带上。

语法:

1 | GET /{索引库名称}/_doc/{id} |

通过kibana查看数据:

1 | GET /heima/_doc/1 |

查看结果:

\讲义\assets\image-20210720213345003.png)

3.3.删除文档

删除使用DELETE请求,同样,需要根据id进行删除:

语法:

1 | DELETE /{索引库名}/_doc/id值 |

示例:

1 | # 根据id删除数据 |

结果:

\讲义\assets\image-20210720213634918.png)

3.4.修改文档

修改有两种方式:

- 全量修改:直接覆盖原来的文档

- 增量修改:修改文档中的部分字段

3.4.1.全量修改

全量修改是覆盖原来的文档,其本质是:

- 根据指定的id删除文档

- 新增一个相同id的文档

注意:如果根据id删除时,id不存在,第二步的新增也会执行,也就从修改变成了新增操作了。

语法:

1 | PUT /{索引库名}/_doc/文档id |

示例:

1 | PUT /heima/_doc/1 |

3.4.2.增量修改

增量修改是只修改指定id匹配的文档中的部分字段。

语法:

1 | POST /{索引库名}/_update/文档id |

示例:

1 | POST /heima/_update/1 |

3.5.总结

文档操作有哪些?

- 创建文档:POST /{索引库名}/_doc/文档id { json文档 }

- 查询文档:GET /{索引库名}/_doc/文档id

- 删除文档:DELETE /{索引库名}/_doc/文档id

- 修改文档:

- 全量修改:PUT /{索引库名}/_doc/文档id { json文档 }

- 增量修改:POST /{索引库名}/_update/文档id { “doc”: {字段}}

4.RestAPI

ES官方提供了各种不同语言的客户端,用来操作ES。这些客户端的本质就是组装DSL语句,通过http请求发送给ES。官方文档地址:https://www.elastic.co/guide/en/elasticsearch/client/index.html

其中的Java Rest Client又包括两种:

- Java Low Level Rest Client

- Java High Level Rest Client

\讲义\assets\image-20210720214555863.png)

我们学习的是Java HighLevel Rest Client客户端API

4.0.导入Demo工程

4.0.1.导入数据

首先导入课前资料提供的数据库数据:

\讲义\assets\image-20210720220400297.png)

数据结构如下:

1 | CREATE TABLE `tb_hotel` ( |

4.0.2.导入项目

然后导入课前资料提供的项目:

\讲义\assets\image-20210720220503411.png)

项目结构如图:

\讲义\assets\image-20210720220647541.png)

4.0.3.mapping映射分析

创建索引库,最关键的是mapping映射,而mapping映射要考虑的信息包括:

- 字段名

- 字段数据类型

- 是否参与搜索

- 是否需要分词

- 如果分词,分词器是什么?

其中:

- 字段名、字段数据类型,可以参考数据表结构的名称和类型

- 是否参与搜索要分析业务来判断,例如图片地址,就无需参与搜索

- 是否分词呢要看内容,内容如果是一个整体就无需分词,反之则要分词

- 分词器,我们可以统一使用ik_max_word

来看下酒店数据的索引库结构:

1 | PUT /hotel |

几个特殊字段说明:

- location:地理坐标,里面包含精度、纬度

- all:一个组合字段,其目的是将多字段的值 利用copy_to合并,提供给用户搜索

地理坐标说明:

\讲义\assets\image-20210720222110126.png)

copy_to说明:

\讲义\assets\image-20210720222221516.png)

4.0.4.初始化RestClient

在elasticsearch提供的API中,与elasticsearch一切交互都封装在一个名为RestHighLevelClient的类中,必须先完成这个对象的初始化,建立与elasticsearch的连接。

分为三步:

1)引入es的RestHighLevelClient依赖:

1 | <dependency> |

2)因为SpringBoot默认的ES版本是7.6.2,所以我们需要覆盖默认的ES版本:

1 | <properties> |

3)初始化RestHighLevelClient:

初始化的代码如下:

1 | RestHighLevelClient client = new RestHighLevelClient(RestClient.builder( |

这里为了单元测试方便,我们创建一个测试类HotelIndexTest,然后将初始化的代码编写在@BeforeEach方法中:

1 | package cn.itcast.hotel; |

4.1.创建索引库

4.1.1.代码解读

创建索引库的API如下:

\讲义\assets\image-20210720223049408.png)

代码分为三步:

- 1)创建Request对象。因为是创建索引库的操作,因此Request是CreateIndexRequest。

- 2)添加请求参数,其实就是DSL的JSON参数部分。因为json字符串很长,这里是定义了静态字符串常量MAPPING_TEMPLATE,让代码看起来更加优雅。

- 3)发送请求,client.indices()方法的返回值是IndicesClient类型,封装了所有与索引库操作有关的方法。

4.1.2.完整示例

在hotel-demo的cn.itcast.hotel.constants包下,创建一个类,定义mapping映射的JSON字符串常量:

1 | package cn.itcast.hotel.constants; |

在hotel-demo中的HotelIndexTest测试类中,编写单元测试,实现创建索引:

1 |

|

4.2.删除索引库

删除索引库的DSL语句非常简单:

1 | DELETE /hotel |

与创建索引库相比:

- 请求方式从PUT变为DELTE

- 请求路径不变

- 无请求参数

所以代码的差异,注意体现在Request对象上。依然是三步走:

- 1)创建Request对象。这次是DeleteIndexRequest对象

- 2)准备参数。这里是无参

- 3)发送请求。改用delete方法

在hotel-demo中的HotelIndexTest测试类中,编写单元测试,实现删除索引:

1 |

|

4.3.判断索引库是否存在

判断索引库是否存在,本质就是查询,对应的DSL是:

1 | GET /hotel |

因此与删除的Java代码流程是类似的。依然是三步走:

- 1)创建Request对象。这次是GetIndexRequest对象

- 2)准备参数。这里是无参

- 3)发送请求。改用exists方法

1 |

|

4.4.总结

JavaRestClient操作elasticsearch的流程基本类似。核心是client.indices()方法来获取索引库的操作对象。

索引库操作的基本步骤:

- 初始化RestHighLevelClient

- 创建XxxIndexRequest。XXX是Create、Get、Delete

- 准备DSL( Create时需要,其它是无参)

- 发送请求。调用RestHighLevelClient#indices().xxx()方法,xxx是create、exists、delete

5.RestClient操作文档

为了与索引库操作分离,我们再次参加一个测试类,做两件事情:

- 初始化RestHighLevelClient

- 我们的酒店数据在数据库,需要利用IHotelService去查询,所以注入这个接口

1 | package cn.itcast.hotel; |

5.1.新增文档

我们要将数据库的酒店数据查询出来,写入elasticsearch中。

5.1.1.索引库实体类

数据库查询后的结果是一个Hotel类型的对象。结构如下:

1 |

|

与我们的索引库结构存在差异:

- longitude和latitude需要合并为location

因此,我们需要定义一个新的类型,与索引库结构吻合:

1 | package cn.itcast.hotel.pojo; |

5.1.2.语法说明

新增文档的DSL语句如下:

1 | POST /{索引库名}/_doc/1 |

对应的java代码如图:

\讲义\assets\image-20210720230027240.png)

可以看到与创建索引库类似,同样是三步走:

- 1)创建Request对象

- 2)准备请求参数,也就是DSL中的JSON文档

- 3)发送请求

变化的地方在于,这里直接使用client.xxx()的API,不再需要client.indices()了。

5.1.3.完整代码

我们导入酒店数据,基本流程一致,但是需要考虑几点变化:

- 酒店数据来自于数据库,我们需要先查询出来,得到hotel对象

- hotel对象需要转为HotelDoc对象

- HotelDoc需要序列化为json格式

因此,代码整体步骤如下:

- 1)根据id查询酒店数据Hotel

- 2)将Hotel封装为HotelDoc

- 3)将HotelDoc序列化为JSON

- 4)创建IndexRequest,指定索引库名和id

- 5)准备请求参数,也就是JSON文档

- 6)发送请求

在hotel-demo的HotelDocumentTest测试类中,编写单元测试:

1 |

|

5.2.查询文档

5.2.1.语法说明

查询的DSL语句如下:

1 | GET /hotel/_doc/{id} |

非常简单,因此代码大概分两步:

- 准备Request对象

- 发送请求

不过查询的目的是得到结果,解析为HotelDoc,因此难点是结果的解析。完整代码如下:

\讲义\assets\image-20210720230811674.png)

可以看到,结果是一个JSON,其中文档放在一个_source属性中,因此解析就是拿到_source,反序列化为Java对象即可。

与之前类似,也是三步走:

- 1)准备Request对象。这次是查询,所以是GetRequest

- 2)发送请求,得到结果。因为是查询,这里调用client.get()方法

- 3)解析结果,就是对JSON做反序列化

5.2.2.完整代码

在hotel-demo的HotelDocumentTest测试类中,编写单元测试:

1 |

|

5.3.删除文档

删除的DSL为是这样的:

1 | DELETE /hotel/_doc/{id} |

与查询相比,仅仅是请求方式从DELETE变成GET,可以想象Java代码应该依然是三步走:

- 1)准备Request对象,因为是删除,这次是DeleteRequest对象。要指定索引库名和id

- 2)准备参数,无参

- 3)发送请求。因为是删除,所以是client.delete()方法

在hotel-demo的HotelDocumentTest测试类中,编写单元测试:

1 |

|

5.4.修改文档

5.4.1.语法说明

修改我们讲过两种方式:

- 全量修改:本质是先根据id删除,再新增

- 增量修改:修改文档中的指定字段值

在RestClient的API中,全量修改与新增的API完全一致,判断依据是ID:

- 如果新增时,ID已经存在,则修改

- 如果新增时,ID不存在,则新增

这里不再赘述,我们主要关注增量修改。

代码示例如图:

\讲义\assets\image-20210720231040875.png)

与之前类似,也是三步走:

- 1)准备Request对象。这次是修改,所以是UpdateRequest

- 2)准备参数。也就是JSON文档,里面包含要修改的字段

- 3)更新文档。这里调用client.update()方法

5.4.2.完整代码

在hotel-demo的HotelDocumentTest测试类中,编写单元测试:

1 |

|

5.5.批量导入文档

案例需求:利用BulkRequest批量将数据库数据导入到索引库中。

步骤如下:

利用mybatis-plus查询酒店数据

将查询到的酒店数据(Hotel)转换为文档类型数据(HotelDoc)

利用JavaRestClient中的BulkRequest批处理,实现批量新增文档

5.5.1.语法说明

批量处理BulkRequest,其本质就是将多个普通的CRUD请求组合在一起发送。

其中提供了一个add方法,用来添加其他请求:

\讲义\assets\image-20210720232105943.png)

可以看到,能添加的请求包括:

- IndexRequest,也就是新增

- UpdateRequest,也就是修改

- DeleteRequest,也就是删除

因此Bulk中添加了多个IndexRequest,就是批量新增功能了。示例:

\讲义\assets\image-20210720232431383.png)

其实还是三步走:

- 1)创建Request对象。这里是BulkRequest

- 2)准备参数。批处理的参数,就是其它Request对象,这里就是多个IndexRequest

- 3)发起请求。这里是批处理,调用的方法为client.bulk()方法

我们在导入酒店数据时,将上述代码改造成for循环处理即可。

5.5.2.完整代码

在hotel-demo的HotelDocumentTest测试类中,编写单元测试:

1 |

|

5.6.小结

文档操作的基本步骤:

- 初始化RestHighLevelClient

- 创建XxxRequest。XXX是Index、Get、Update、Delete、Bulk

- 准备参数(Index、Update、Bulk时需要)

- 发送请求。调用RestHighLevelClient#.xxx()方法,xxx是index、get、update、delete、bulk

- 解析结果(Get时需要)

1.DSL查询文档

elasticsearch的查询依然是基于JSON风格的DSL来实现的。

1.1.DSL查询分类

Elasticsearch提供了基于JSON的DSL(Domain Specific Language)来定义查询。常见的查询类型包括:

查询所有:查询出所有数据,一般测试用。例如:match_all

全文检索(full text)查询:利用分词器对用户输入内容分词,然后去倒排索引库中匹配。例如:

- match_query

- multi_match_query

精确查询:根据精确词条值查找数据,一般是查找keyword、数值、日期、boolean等类型字段。例如:

- ids

- range

- term

地理(geo)查询:根据经纬度查询。例如:

- geo_distance

- geo_bounding_box

复合(compound)查询:复合查询可以将上述各种查询条件组合起来,合并查询条件。例如:

- bool

- function_score

查询的语法基本一致:

1 | GET /indexName/_search |

我们以查询所有为例,其中:

- 查询类型为match_all

- 没有查询条件

1 | // 查询所有 |

其它查询无非就是查询类型、查询条件的变化。

1.2.全文检索查询

1.2.1.使用场景

全文检索查询的基本流程如下:

- 对用户搜索的内容做分词,得到词条

- 根据词条去倒排索引库中匹配,得到文档id

- 根据文档id找到文档,返回给用户

比较常用的场景包括:

- 商城的输入框搜索

- 百度输入框搜索

例如京东:

因为是拿着词条去匹配,因此参与搜索的字段也必须是可分词的text类型的字段。

1.2.2.基本语法

常见的全文检索查询包括:

- match查询:单字段查询

- multi_match查询:多字段查询,任意一个字段符合条件就算符合查询条件

match查询语法如下:

1 | GET /indexName/_search |

mulit_match语法如下:

1 | GET /indexName/_search |

1.2.3.示例

match查询示例:

multi_match查询示例:

可以看到,两种查询结果是一样的,为什么?

因为我们将brand、name、business值都利用copy_to复制到了all字段中。因此你根据三个字段搜索,和根据all字段搜索效果当然一样了。

但是,搜索字段越多,对查询性能影响越大,因此建议采用copy_to,然后单字段查询的方式。

1.2.4.总结

match和multi_match的区别是什么?

- match:根据一个字段查询

- multi_match:根据多个字段查询,参与查询字段越多,查询性能越差

1.3.精准查询

精确查询一般是查找keyword、数值、日期、boolean等类型字段。所以不会对搜索条件分词。常见的有:

- term:根据词条精确值查询

- range:根据值的范围查询

1.3.1.term查询

因为精确查询的字段搜是不分词的字段,因此查询的条件也必须是不分词的词条。查询时,用户输入的内容跟自动值完全匹配时才认为符合条件。如果用户输入的内容过多,反而搜索不到数据。

语法说明:

1 | // term查询 |

示例:

当我搜索的是精确词条时,能正确查询出结果:

但是,当我搜索的内容不是词条,而是多个词语形成的短语时,反而搜索不到:

1.3.2.range查询

范围查询,一般应用在对数值类型做范围过滤的时候。比如做价格范围过滤。

基本语法:

1 | // range查询 |

示例:

1.3.3.总结

精确查询常见的有哪些?

- term查询:根据词条精确匹配,一般搜索keyword类型、数值类型、布尔类型、日期类型字段

- range查询:根据数值范围查询,可以是数值、日期的范围

1.4.地理坐标查询

所谓的地理坐标查询,其实就是根据经纬度查询,官方文档:https://www.elastic.co/guide/en/elasticsearch/reference/current/geo-queries.html

常见的使用场景包括:

- 携程:搜索我附近的酒店

- 滴滴:搜索我附近的出租车

- 微信:搜索我附近的人

附近的酒店:

附近的车:

1.4.1.矩形范围查询

矩形范围查询,也就是geo_bounding_box查询,查询坐标落在某个矩形范围的所有文档:

查询时,需要指定矩形的左上、右下两个点的坐标,然后画出一个矩形,落在该矩形内的都是符合条件的点。

语法如下:

1 | // geo_bounding_box查询 |

这种并不符合“附近的人”这样的需求,所以我们就不做了。

1.4.2.附近查询

附近查询,也叫做距离查询(geo_distance):查询到指定中心点小于某个距离值的所有文档。

换句话来说,在地图上找一个点作为圆心,以指定距离为半径,画一个圆,落在圆内的坐标都算符合条件:

语法说明:

1 | // geo_distance 查询 |

示例:

我们先搜索陆家嘴附近15km的酒店:

发现共有47家酒店。

然后把半径缩短到3公里:

可以发现,搜索到的酒店数量减少到了5家。

1.5.复合查询

复合(compound)查询:复合查询可以将其它简单查询组合起来,实现更复杂的搜索逻辑。常见的有两种:

- fuction score:算分函数查询,可以控制文档相关性算分,控制文档排名

- bool query:布尔查询,利用逻辑关系组合多个其它的查询,实现复杂搜索

1.5.1.相关性算分

当我们利用match查询时,文档结果会根据与搜索词条的关联度打分(_score),返回结果时按照分值降序排列。

例如,我们搜索 “虹桥如家”,结果如下:

1 | [ |

在elasticsearch中,早期使用的打分算法是TF-IDF算法,公式如下:

在后来的5.1版本升级中,elasticsearch将算法改进为BM25算法,公式如下:

TF-IDF算法有一各缺陷,就是词条频率越高,文档得分也会越高,单个词条对文档影响较大。而BM25则会让单个词条的算分有一个上限,曲线更加平滑:

小结:elasticsearch会根据词条和文档的相关度做打分,算法由两种:

- TF-IDF算法

- BM25算法,elasticsearch5.1版本后采用的算法

1.5.2.算分函数查询

根据相关度打分是比较合理的需求,但合理的不一定是产品经理需要的。

以百度为例,你搜索的结果中,并不是相关度越高排名越靠前,而是谁掏的钱多排名就越靠前。如图:

要想认为控制相关性算分,就需要利用elasticsearch中的function score 查询了。

1)语法说明

function score 查询中包含四部分内容:

- 原始查询条件:query部分,基于这个条件搜索文档,并且基于BM25算法给文档打分,原始算分(query score)

- 过滤条件:filter部分,符合该条件的文档才会重新算分

- 算分函数:符合filter条件的文档要根据这个函数做运算,得到的函数算分(function score),有四种函数

- weight:函数结果是常量

- field_value_factor:以文档中的某个字段值作为函数结果

- random_score:以随机数作为函数结果

- script_score:自定义算分函数算法

- 运算模式:算分函数的结果、原始查询的相关性算分,两者之间的运算方式,包括:

- multiply:相乘

- replace:用function score替换query score

- 其它,例如:sum、avg、max、min

function score的运行流程如下:

- 1)根据原始条件查询搜索文档,并且计算相关性算分,称为原始算分(query score)

- 2)根据过滤条件,过滤文档

- 3)符合过滤条件的文档,基于算分函数运算,得到函数算分(function score)

- 4)将原始算分(query score)和函数算分(function score)基于运算模式做运算,得到最终结果,作为相关性算分。

因此,其中的关键点是:

- 过滤条件:决定哪些文档的算分被修改

- 算分函数:决定函数算分的算法

- 运算模式:决定最终算分结果

2)示例

需求:给“如家”这个品牌的酒店排名靠前一些

翻译一下这个需求,转换为之前说的四个要点:

- 原始条件:不确定,可以任意变化

- 过滤条件:brand = “如家”

- 算分函数:可以简单粗暴,直接给固定的算分结果,weight

- 运算模式:比如求和

因此最终的DSL语句如下:

1 | GET /hotel/_search |

测试,在未添加算分函数时,如家得分如下:

添加了算分函数后,如家得分就提升了:

3)小结

function score query定义的三要素是什么?

- 过滤条件:哪些文档要加分

- 算分函数:如何计算function score

- 加权方式:function score 与 query score如何运算

1.5.3.布尔查询

布尔查询是一个或多个查询子句的组合,每一个子句就是一个子查询。子查询的组合方式有:

- must:必须匹配每个子查询,类似“与”

- should:选择性匹配子查询,类似“或”

- must_not:必须不匹配,不参与算分,类似“非”

- filter:必须匹配,不参与算分

比如在搜索酒店时,除了关键字搜索外,我们还可能根据品牌、价格、城市等字段做过滤:

每一个不同的字段,其查询的条件、方式都不一样,必须是多个不同的查询,而要组合这些查询,就必须用bool查询了。

需要注意的是,搜索时,参与打分的字段越多,查询的性能也越差。因此这种多条件查询时,建议这样做:

- 搜索框的关键字搜索,是全文检索查询,使用must查询,参与算分

- 其它过滤条件,采用filter查询。不参与算分

1)语法示例:

1 | GET /hotel/_search |

2)示例

需求:搜索名字包含“如家”,价格不高于400,在坐标31.21,121.5周围10km范围内的酒店。

分析:

- 名称搜索,属于全文检索查询,应该参与算分。放到must中

- 价格不高于400,用range查询,属于过滤条件,不参与算分。放到must_not中

- 周围10km范围内,用geo_distance查询,属于过滤条件,不参与算分。放到filter中

3)小结

bool查询有几种逻辑关系?

- must:必须匹配的条件,可以理解为“与”

- should:选择性匹配的条件,可以理解为“或”

- must_not:必须不匹配的条件,不参与打分

- filter:必须匹配的条件,不参与打分

2.搜索结果处理

搜索的结果可以按照用户指定的方式去处理或展示。

2.1.排序

elasticsearch默认是根据相关度算分(_score)来排序,但是也支持自定义方式对搜索结果排序。可以排序字段类型有:keyword类型、数值类型、地理坐标类型、日期类型等。

2.1.1.普通字段排序

keyword、数值、日期类型排序的语法基本一致。

语法:

1 | GET /indexName/_search |

排序条件是一个数组,也就是可以写多个排序条件。按照声明的顺序,当第一个条件相等时,再按照第二个条件排序,以此类推

示例:

需求描述:酒店数据按照用户评价(score)降序排序,评价相同的按照价格(price)升序排序

2.1.2.地理坐标排序

地理坐标排序略有不同。

语法说明:

1 | GET /indexName/_search |

这个查询的含义是:

- 指定一个坐标,作为目标点

- 计算每一个文档中,指定字段(必须是geo_point类型)的坐标 到目标点的距离是多少

- 根据距离排序

示例:

需求描述:实现对酒店数据按照到你的位置坐标的距离升序排序

提示:获取你的位置的经纬度的方式:https://lbs.amap.com/demo/jsapi-v2/example/map/click-to-get-lnglat/

假设我的位置是:31.034661,121.612282,寻找我周围距离最近的酒店。

2.2.分页

elasticsearch 默认情况下只返回top10的数据。而如果要查询更多数据就需要修改分页参数了。elasticsearch中通过修改from、size参数来控制要返回的分页结果:

- from:从第几个文档开始

- size:总共查询几个文档

类似于mysql中的limit ?, ?

2.2.1.基本的分页

分页的基本语法如下:

1 | GET /hotel/_search |

2.2.2.深度分页问题

现在,我要查询990~1000的数据,查询逻辑要这么写:

1 | GET /hotel/_search |

这里是查询990开始的数据,也就是 第990~第1000条 数据。

不过,elasticsearch内部分页时,必须先查询 0~1000条,然后截取其中的990 ~ 1000的这10条:

查询TOP1000,如果es是单点模式,这并无太大影响。

但是elasticsearch将来一定是集群,例如我集群有5个节点,我要查询TOP1000的数据,并不是每个节点查询200条就可以了。

因为节点A的TOP200,在另一个节点可能排到10000名以外了。

因此要想获取整个集群的TOP1000,必须先查询出每个节点的TOP1000,汇总结果后,重新排名,重新截取TOP1000。

那如果我要查询9900~10000的数据呢?是不是要先查询TOP10000呢?那每个节点都要查询10000条?汇总到内存中?

当查询分页深度较大时,汇总数据过多,对内存和CPU会产生非常大的压力,因此elasticsearch会禁止from+ size 超过10000的请求。

针对深度分页,ES提供了两种解决方案,官方文档:

- search after:分页时需要排序,原理是从上一次的排序值开始,查询下一页数据。官方推荐使用的方式。

- scroll:原理将排序后的文档id形成快照,保存在内存。官方已经不推荐使用。

2.2.3.小结

分页查询的常见实现方案以及优缺点:

from + size:- 优点:支持随机翻页

- 缺点:深度分页问题,默认查询上限(from + size)是10000

- 场景:百度、京东、谷歌、淘宝这样的随机翻页搜索

after search:- 优点:没有查询上限(单次查询的size不超过10000)

- 缺点:只能向后逐页查询,不支持随机翻页

- 场景:没有随机翻页需求的搜索,例如手机向下滚动翻页

scroll:- 优点:没有查询上限(单次查询的size不超过10000)

- 缺点:会有额外内存消耗,并且搜索结果是非实时的

- 场景:海量数据的获取和迁移。从ES7.1开始不推荐,建议用 after search方案。

2.3.高亮

2.3.1.高亮原理

什么是高亮显示呢?

我们在百度,京东搜索时,关键字会变成红色,比较醒目,这叫高亮显示:

高亮显示的实现分为两步:

- 1)给文档中的所有关键字都添加一个标签,例如

<em>标签 - 2)页面给

<em>标签编写CSS样式

2.3.2.实现高亮

高亮的语法:

1 | GET /hotel/_search |

注意:

- 高亮是对关键字高亮,因此搜索条件必须带有关键字,而不能是范围这样的查询。

- 默认情况下,高亮的字段,必须与搜索指定的字段一致,否则无法高亮

- 如果要对非搜索字段高亮,则需要添加一个属性:required_field_match=false

示例:

2.4.总结

查询的DSL是一个大的JSON对象,包含下列属性:

- query:查询条件

- from和size:分页条件

- sort:排序条件

- highlight:高亮条件

示例:

3.RestClient查询文档

文档的查询同样适用昨天学习的 RestHighLevelClient对象,基本步骤包括:

- 1)准备Request对象

- 2)准备请求参数

- 3)发起请求

- 4)解析响应

3.1.快速入门

我们以match_all查询为例

3.1.1.发起查询请求

代码解读:

第一步,创建

SearchRequest对象,指定索引库名第二步,利用

request.source()构建DSL,DSL中可以包含查询、分页、排序、高亮等query():代表查询条件,利用QueryBuilders.matchAllQuery()构建一个match_all查询的DSL

第三步,利用client.search()发送请求,得到响应

这里关键的API有两个,一个是request.source(),其中包含了查询、排序、分页、高亮等所有功能:

另一个是QueryBuilders,其中包含match、term、function_score、bool等各种查询:

3.1.2.解析响应

响应结果的解析:

elasticsearch返回的结果是一个JSON字符串,结构包含:

hits:命中的结果total:总条数,其中的value是具体的总条数值max_score:所有结果中得分最高的文档的相关性算分hits:搜索结果的文档数组,其中的每个文档都是一个json对象_source:文档中的原始数据,也是json对象

因此,我们解析响应结果,就是逐层解析JSON字符串,流程如下:

SearchHits:通过response.getHits()获取,就是JSON中的最外层的hits,代表命中的结果SearchHits#getTotalHits().value:获取总条数信息SearchHits#getHits():获取SearchHit数组,也就是文档数组SearchHit#getSourceAsString():获取文档结果中的_source,也就是原始的json文档数据

3.1.3.完整代码

完整代码如下:

1 |

|

3.1.4.小结

查询的基本步骤是:

创建SearchRequest对象

准备Request.source(),也就是DSL。

① QueryBuilders来构建查询条件

② 传入Request.source() 的 query() 方法

发送请求,得到结果

解析结果(参考JSON结果,从外到内,逐层解析)

3.2.match查询

全文检索的match和multi_match查询与match_all的API基本一致。差别是查询条件,也就是query的部分。

因此,Java代码上的差异主要是request.source().query()中的参数了。同样是利用QueryBuilders提供的方法:

而结果解析代码则完全一致,可以抽取并共享。

完整代码如下:

1 |

|

3.3.精确查询

精确查询主要是两者:

- term:词条精确匹配

- range:范围查询

与之前的查询相比,差异同样在查询条件,其它都一样。

查询条件构造的API如下:

3.4.布尔查询

布尔查询是用must、must_not、filter等方式组合其它查询,代码示例如下:

可以看到,API与其它查询的差别同样是在查询条件的构建,QueryBuilders,结果解析等其他代码完全不变。

完整代码如下:

1 |

|

3.5.排序、分页

搜索结果的排序和分页是与query同级的参数,因此同样是使用request.source()来设置。

对应的API如下:

完整代码示例:

1 |

|

3.6.高亮

高亮的代码与之前代码差异较大,有两点:

- 查询的DSL:其中除了查询条件,还需要添加高亮条件,同样是与query同级。

- 结果解析:结果除了要解析_source文档数据,还要解析高亮结果

3.6.1.高亮请求构建

高亮请求的构建API如下:

上述代码省略了查询条件部分,但是大家不要忘了:高亮查询必须使用全文检索查询,并且要有搜索关键字,将来才可以对关键字高亮。

完整代码如下:

1 |

|

3.6.2.高亮结果解析

高亮的结果与查询的文档结果默认是分离的,并不在一起。

因此解析高亮的代码需要额外处理:

代码解读:

- 第一步:从结果中获取source。hit.getSourceAsString(),这部分是非高亮结果,json字符串。还需要反序列为HotelDoc对象

- 第二步:获取高亮结果。hit.getHighlightFields(),返回值是一个Map,key是高亮字段名称,值是HighlightField对象,代表高亮值

- 第三步:从map中根据高亮字段名称,获取高亮字段值对象HighlightField

- 第四步:从HighlightField中获取Fragments,并且转为字符串。这部分就是真正的高亮字符串了

- 第五步:用高亮的结果替换HotelDoc中的非高亮结果

完整代码如下:

1 | private void handleResponse(SearchResponse response) { |